Regelmäßige und rechtzeitige Serverwartung spart Kosten und senkt Unternehmensrisiken. Worauf es dabei besonders ankommt und worauf Unternehmen bei der Wartung ihrer Server achten müssen, zeigt unser Praxisbeitrag.

TL;DR: Kurzüberblick

- Regelmäßige Serverwartung umfasst Hardware- und Software-Pflege, um Ausfälle zu vermeiden und Sicherheit sowie Performance sicherzustellen.

- Präventive Wartung ist entscheidend: Damit lassen sich Serverausfälle und Security Incidents deutlich reduzieren.

- Wartungsroutinen sollten tägliche Checks (Backups, Logs, Auslastung) und monatliche Tasks (Hardware-Inspektion, Updates, Berechtigungsprüfung etc.) umfassen, um Probleme frühzeitig zu erkennen.

- Dokumentation ist nicht optional: Eine lückenlose Dokumentation aller Systeme, Konfigurationen und durchgeführten Wartungsarbeiten ist entscheidend. Sie ermöglicht eine schnelle und effiziente Fehlerbehebung, sichert die Compliance und ist unerlässlich für die Übergabe von Verantwortung oder die Zusammenarbeit mit externen Dienstleistern.

- Der Mensch ist ein entscheidender Faktor: Ob es sich um das interne IT-Team oder einen externen Managed-Service-Anbieter handelt – die Expertise, Zuverlässigkeit und Sorgfalt der verantwortlichen Personen sind der Schlüssel zum Erfolg. Die besten Werkzeuge und Prozesse sind wirkungslos in den falschen Händen.

Professionelle Hilfe: Fehlen Know-how oder Ressourcen, lohnt ein externer Server-Wartungsvertrag – oft günstiger als eigene IT und mit 24/7-Support

Zielgruppe und Nutzen des Beitrags

Dieser Praxisleitfaden richtet sich an Unternehmen mit eigenen Servern, insbesondere kleine und mittelständische Firmen, die vielleicht keine großen IT-Abteilungen haben. Er ist bewusst praxisnah und verständlich formuliert, damit auch Leser ohne Expertenwissen das Thema Serverwartung nachvollziehen können. Sie erfahren, was Serverwartung genau umfasst und warum sie so wichtig ist – von der Steigerung der Verfügbarkeit und Performance bis zur Erfüllung von Sicherheits- und Datenschutzauflagen.

Warum Serverwartung wichtig ist

Eine vernachlässigte Serverwartung kann fatale Folgen haben: Ungeplante Serverausfälle legen Arbeitsprozesse lahm und verursachen hohe Kosten. Laut einer Studie von Gartner kann eine Minute Downtime umgerechnet etwa 5.000 Euro kosten. Regelmäßige Serverwartung ist deshalb keine lästige Pflicht, sondern eine Investition in Stabilität und Sicherheit der IT-Umgebung. Durch vorbeugende Pflege lassen sich Probleme erkennen und beheben, bevor sie den Betrieb stören. So werden teure Downtimes und Datenverluste vermieden und die Betriebszeit maximiert.

Die Wartungsaufgaben unterteilen sich je nach notwendigem Intervall in die folgenden Gruppen:

- Tägliche Prüfungen

- Wöchentliche Prüfungen

- Monatliche Prüfungen

- Quartalsweise oder jährliche Prüfungen

Checkliste für die Serverwartung

Unsere Checkliste dient als praktische Vorlage für die Durchführung regelmäßiger Wartungsarbeiten. Sie kann an die spezifischen Bedürfnisse und die Infrastruktur Ihres Unternehmens angepasst und für die Dokumentation genutzt werden.

1. Tägliche Prüfungen

- Backup-Status: Alle Backup-Jobs des Vortages auf erfolgreichen Abschluss prüfen. Fehlgeschlagene Backups sofort analysieren und erneut anstoßen.

- Kritische System-Alerts: Ereignisprotokolle (Windows Event Viewer, Linux /var/log) auf kritische Fehler (Error-Level) und wiederkehrende Warnungen (Warning-Level) überprüfen.

- Performance-Monitoring: Dashboard-Ansicht der CPU-, RAM- und Festplattenauslastung kontrollieren. Auf unerklärliche Lastspitzen achten.

- Antivirus-Status: Überprüfen, ob der Virenscanner auf allen Servern aktiv ist und die Signaturen erfolgreich aktualisiert wurden.

2. Wöchentliche Prüfungen

- Nicht-kritische Patches: Verfügbare Sicherheitsupdates für Betriebssysteme und Standardanwendungen prüfen und installieren (nach vorherigem Test, falls möglich).

- Speicherplatz-Analyse: Festplattenbelegung prüfen und den Zuwachs der letzten Woche analysieren. Bei weniger als 15% freiem Speicherplatz Maßnahmen zur Bereinigung oder Erweiterung planen.

- Test-Restore (Datei-Ebene): Eine zufällig ausgewählte Datei oder einen Ordner aus dem Backup an einem temporären Ort wiederherstellen, um die Lesbarkeit der Sicherung zu bestätigen.

- Hardware-Status (Remote): RAID-Controller-Status und SMART-Werte der Festplatten über Verwaltungstools auslesen.

- Externe Erreichbarkeit: Kritische Dienste (z.B. Website, E-Mail-Server) von einem externen Netz aus auf Erreichbarkeit und korrekte Funktion prüfen.

3. Monatliche Prüfungen

- Kritische OS-Updates (Patch-Day): Wichtige Sicherheitsupdates des Betriebssystemherstellers (z.B. Microsoft Patch Tuesday) nach Test in der Staging-Umgebung auf den Produktivsystemen installieren.

- Anwendungsupdates: Updates für kritische Fachanwendungen (z.B. ERP, CRM, Datenbanken) nach Herstellerfreigabe und Test einspielen.

- Benutzerkonten-Review: Alle Benutzerkonten (insb. mit administrativen Rechten) auf Notwendigkeit prüfen. Konten von ausgeschiedenen Mitarbeitern deaktivieren/löschen.

- Bereinigung: Temporäre Dateien, alte Logfiles und nicht mehr benötigte Software-Installationen entfernen.

- Test-Restore (Anwendungs-Ebene): Eine kleine Datenbank oder eine komplette virtuelle Maschine in einer isolierten Testumgebung wiederherstellen.

4. Quartalsweise / jährliche Prüfungen

- Serverraum auf Sauberkeit und Ordnung prüfen.

- Server herunterfahren, Gehäuse öffnen und vorsichtig mit Druckluft und ESD-sicherem Staubsauger von Staub befreien.

- Alle Lüfter auf freie Drehbarkeit und ungewöhnliche Geräusche prüfen.

- Alle internen und externen Kabelverbindungen auf festen Sitz kontrollieren.

- Passwort-Rotation: Alle administrativen Passwörter und Passwörter von Dienstkonten (Service Accounts) ändern.

- Dokumentations-Audit (jährlich): Die gesamte System- und Netzwerdokumentation auf Aktualität und Vollständigkeit überprüfen und bei Bedarf anpassen.

- Disaster-Recovery-Test (jährlich): Einen vollständigen Ausfall eines Standorts oder des primären Systems simulieren und den kompletten Wiederanlaufprozess aus den Off-Site-Backups durchspielen. Zeit bis zur Wiederherstellung (RTO) und Datenverlust (RPO) messen und mit den Geschäftsanforderungen abgleichen.

- Überprüfung des Wartungsvertrags (jährlich): Bei externen Dienstleistern den Service-Vertrag und die SLAs auf Aktualität und Angemessenheit prüfen.

Grundlagen der Serverwartung

Hardware- vs. Softwarewartung – was heißt das konkret?

Obwohl Hardware- und Softwarewartung oft in einem Atemzug genannt werden, beziehen sie sich auf unterschiedliche Aspekte eines Serversystems.

Hardwarewartung ist die physische Pflege und Überwachung der Serverkomponenten. Dazu gehören Aufgaben wie die regelmäßige Reinigung der Geräte und des Serverraums von Staub, der die Kühlung blockieren und zu Überhitzung führen kann. Ebenso wichtig ist die Überwachung der Umgebungsbedingungen wie Temperatur und Luftfeuchtigkeit sowie die Überprüfung der unterbrechungsfreien Stromversorgung (USV). Zentral ist zudem die proaktive Kontrolle von Verschleißteilen, insbesondere von Festplatten (HDDs) und Solid-State-Drives (SSDs), deren Gesundheitszustand (z.B. über SMART-Werte) Aufschluss über einen drohenden Ausfall geben kann. Ziel der Hardwarewartung ist es, physische Defekte zu verhindern, bevor sie zu einem Systemausfall führen.

Die Softwarewartung hingegen ist die „digitale Hygiene" des Servers. Sie umfasst alle Maßnahmen, die auf der Ebene des Betriebssystems und der darauf installierten Anwendungen stattfinden. Die Kernaufgaben sind hier das regelmäßige Einspielen von Updates für das Betriebssystem (z.B. Windows Server oder Linux-Distributionen) und die Aktualisierung der Firmware, also der grundlegenden Steuerungssoftware der Hardwarekomponenten.

Der wohl kritischste Aspekt der Software-Wartung ist das Patch-Management: das gezielte Schließen von bekannten Sicherheitslücken in Anwenderprogrammen wie Webservern, Datenbanken oder branchenspezifischer Software. Ziel der Software-Wartung ist es, die Sicherheit, Stabilität und Kompatibilität der Systeme zu gewährleisten.

Hardware- und Softwarewartung sind untrennbar miteinander verbunden. Ein Softwarefehler wie ein außer Kontrolle geratener Prozess kann die CPU-Auslastung in die Höhe treiben und zu physischer Überhitzung führen. Umgekehrt kann ein defekter Hardware-Baustein, etwa ein fehlerhafter RAM-Riegel, zu ständigen Software-Abstürzen führen. Ein ganzheitlicher Wartungsplan muss daher zwingend beide Aspekte umfassen, da die Vernachlässigung eines Bereichs unweigerlich die Stabilität des anderen gefährdet und das Gesamtrisiko eines Ausfalls signifikant erhöht.

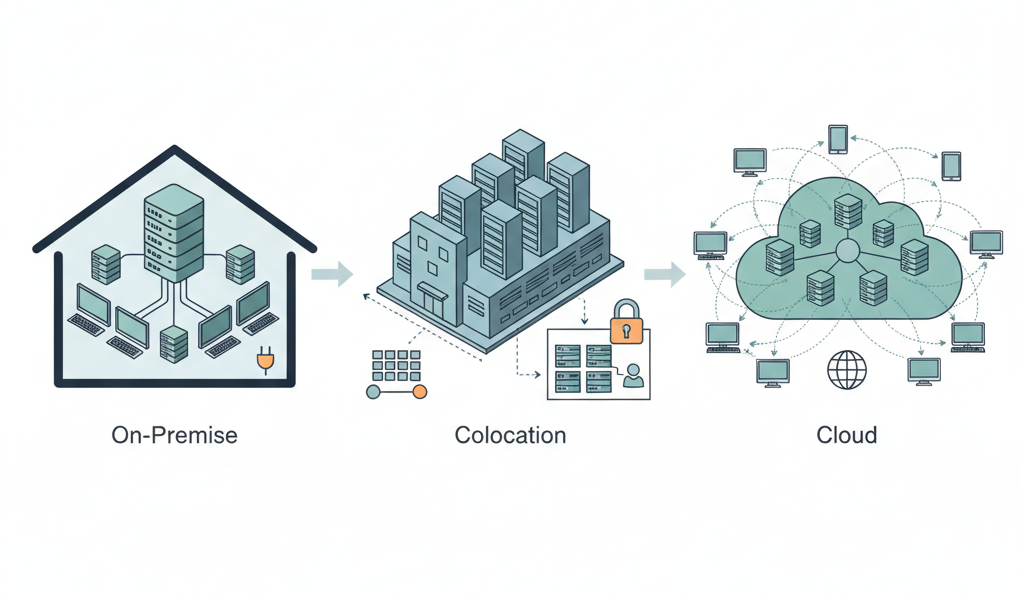

On-Premises, Colocation oder Cloud

Der Umfang der Wartung hängt maßgeblich davon ab, wo und wie ein Unternehmen seine Server betreibt.

Bei Servern On-Premises besitzt das Unternehmen die Server und betreibt sie in den eigenen Räumlichkeiten, beispielsweise in einem dedizierten Serverraum. Hier liegt die volle Verantwortung für alle Wartungsaspekte beim Unternehmen – von der physischen Sicherheit und Klimatisierung über den Austausch defekter Hardware bis hin zur gesamten Softwarepflege. Dieses Modell bietet maximale Kontrolle, erfordert aber auch die höchsten Investitionen (CapEx) und das meiste interne Know-how.

Bei einer Colocation-Lösung besitzt das Unternehmen ebenfalls die Server, mietet jedoch Stellplatz, Strom, Kühlung und Netzwerkanbindung in einem professionellen Rechenzentrum eines Drittanbieters. Die Wartungsverantwortung ist hier geteilt: Der Anbieter kümmert sich um die gesamte Gebäudeinfrastruktur (physische Sicherheit, redundante Stromversorgung, Klimatisierung), während das Unternehmen weiterhin für die Wartung seiner eigenen Hardware (z.B. Austausch einer Festplatte) und der darauf laufenden Software verantwortlich bleibt. Dieses Modell wandelt einen Teil der Infrastrukturkosten in planbare Betriebsausgaben (OpEx) um und profitiert von der professionellen Umgebung des Rechenzentrums.

Und schließlich gibt es noch den cloudbasierten Ansatz (Infrastructure as a Service – IaaS): Hier mietet das Unternehmen virtuelle Server bei einem Hyperscaler wie Amazon Web Services (AWS), Microsoft Azure oder Google Cloud. Die Verantwortung für die gesamte physische Infrastruktur liegt hier beim Anbieter. Der Kunde ist nur noch für die Wartung des virtuellen Servers zuständig, also für das Betriebssystem, die Patches und die Anwendungen. Dieses Modell ist vollständig OpEx-basiert und bietet höchste Flexibilität, geht aber mit geringerer Kontrolle über die zugrundeliegende Hardware einher.

Die folgende Tabelle verdeutlicht die unterschiedlichen Verantwortlichkeiten und Merkmale:

| Aspekt | On-Premises | Colocation | Cloud (IaaS) |

| Physische Sicherheit | Volle Verantwortung (Unternehmen) | Verantwortung des Anbieters | Verantwortung des Anbieters |

| Kühlung & Strom | Volle Verantwortung (Unternehmen) | Verantwortung des Anbieters | Verantwortung des Anbieters |

| Hardware-Wartung | Volle Verantwortung (Unternehmen) | Volle Verantwortung (Unternehmen) | Verantwortung des Anbieters |

| OS & Patch-Management | Volle Verantwortung (Unternehmen) | Volle Verantwortung (Unternehmen) | Geteilte Verantwortung |

| Netzwerkinfrastruktur | Volle Verantwortung (Unternehmen) | Geteilte Verantwortung | Verantwortung des Anbieters |

| Kostenmodell | Hohe Investitionskosten (CapEx) | Mix aus CapEx und OpEx | Betriebskosten (OpEx) |

| Kontrolle | Maximal | Hoch | Gering (über Hardware) |

| Skalierbarkeit | Gering / Aufwendig | Mittel | Sehr hoch |

Dieser Leitfaden fokussiert sich auf die Wartungsaufgaben, die im On-Premises- und Colocation-Modell anfallen, weil hier die Verantwortung für die Hardware direkt beim Unternehmen liegt.

Ziele der Wartung

Maximale Verfügbarkeit und Performance

Das primäre und offensichtlichste Ziel der Wartung ist die Sicherstellung einer maximalen Verfügbarkeit der IT-Systeme. Jeder ungeplante Ausfall eines kritischen Servers führt zu einem Stillstand von Geschäftsprozessen. Mitarbeiter können nicht arbeiten, Kunden können keine Bestellungen aufgeben, und Produktionsabläufe werden unterbrochen. Proaktive Wartung identifiziert und behebt potenzielle Fehlerquellen, bevor sie zu einem Ausfall führen, und minimiert so die Downtime.

Eng damit verknüpft ist die Performance. Ein langsamer Server ist fast so schädlich wie ein ausgefallener. Wenn Anwendungen nur schleppend reagieren, sinkt die Produktivität der Mitarbeiter, und die Frustration steigt. Für kundenorientierte Systeme, wie einen Online-Shop, führen lange Ladezeiten nachweislich zu geringeren Konversionsraten und einem schlechten Kundenerlebnis. Regelmäßige Wartung, wie die Optimierung von Datenbanken, die Bereinigung von temporären Dateien und die Überwachung der Ressourcenauslastung, sorgt dafür, dass die Server stets mit optimaler Geschwindigkeit arbeiten.

Sicherheit, Compliance & Datenschutz

Server sind ständigen Bedrohungen ausgesetzt – von Malware über Hackerangriffe bis zu internen Fehlern. Durch regelmäßige Updates und Patches werden bekannte Sicherheitslücken geschlossen, bevor Angreifer sie ausnutzen können.

Ein zentrales Ziel der Serverwartung ist es daher, die Angriffsfläche zu minimieren und die Systeme zu härten. Das geschieht vor allem durch konsequentes Patch-Management, das bekannte Sicherheitslücken schließt, bevor sie ausgenutzt werden können.

Darüber hinaus ist die Einhaltung gesetzlicher und regulatorischer Vorgaben (Compliance) ein weiteres wichtiges Ziel. Vorschriften wie die Datenschutz-Grundverordnung (DSGVO) fordern explizit technische und organisatorische Maßnahmen zum Schutz personenbezogener Daten. Auch branchenspezifische Standards wie die ISO 27001 für Informationssicherheit oder spezielle Anforderungen im Gesundheitswesen (z.B. für Arztpraxen) setzen eine lückenlos dokumentierte und professionell durchgeführte Wartung voraus. Eine vernachlässigte Wartung ist nicht nur ein Sicherheitsrisiko, sondern auch ein Compliance-Verstoß, der zu empfindlichen Strafen führen kann.

Längere Lebensdauer und geringere Gesamtbetriebskosten

Gut gewartete Server halten spürbar länger. Durch proaktive Pflege wie das Reinigen von Staub oder das rechtzeitige Austauschen von Verschleißteilen wie Lüftern oder Festplatten wird Materialermüdung vorgebeugt und die Lebensdauer der teuren Hardware verlängert. Ein defekter Lüfter etwa, der unbemerkt bleibt, kann eine gefährliche Kettenreaktion auslösen (Überhitzung weiterer Komponenten bis hin zum Totalausfall).

Wartung bewahrt also vor Folgeschäden. Die Gesamtbetriebskosten (TCO) sinken dadurch langfristig: Jeder Tag, den ein Server länger zuverlässig arbeitet, spart Anschaffungskosten für Ersatzgeräte. Außerdem verursachen Notfalleinsätze und ungeplante Reparaturen oft höhere Kosten als planmäßige Wartungsarbeiten. Präventive Wartung spart Geld, indem sie teure Ausfälle verhindert.

Zusätzlich können Unternehmen durch eine optimierte Wartung ihre Infrastruktur effizienter nutzen: Beispielsweise lassen sich durch Performance-Monitoring Überkapazitäten abbauen oder Engpässe gezielt beheben, anstatt vorschnell neue Hardware zu kaufen. Auch Energieeinsparungen sind möglich. Zum Beispiel laufen gut gewartete Kühlsysteme effizienter, und ein staubfreier Server verbraucht weniger Strom zur Kühlung.

Kernaufgaben im Wartungszyklus

Hardware-Inspektion

Ein wichtiger Teil der Serverwartung ist die regelmäßige Hardware-Inspektion. Hierbei wird der Server physisch geprüft, um mögliche Probleme frühzeitig zu erkennen. Dazu gehören:

- Temperatur und Kühlung: Stellen Sie sicher, dass der Server nicht überhitzt. Überprüfen Sie, ob alle Lüfter laufen und Lüftungswege frei sind. Entfernen Sie Staub aus Lufteinlässen, vom CPU-Kühler und den Lüfterblättern, denn Staub wirkt wie ein Wärmedämmstoff und kann zu Hitzestau führen. Idealerweise schaltet man den Server im Wartungsfenster ab, entnimmt ihn aus dem Rack und bläst ihn an einem antistatischen Arbeitsplatz mit Druckluft aus. Das senkt die Betriebstemperatur und verhindert temperaturbedingte Komponenten-Ausfälle.

- Stromversorgung & USV: Prüfen Sie alle Kabelverbindungen und Netzteile. Hat der Server redundante Netzteile, laufen beide einwandfrei? Eine unterbrechungsfreie Stromversorgung (USV) sollte regelmäßig getestet werden. Testen Sie monatlich die USV-Batterien, weil diese altern; sie müssen im Ernstfall genug Zeit für ein geordnetes Herunterfahren bieten. Ein fehlender oder defekter USV-Schutz könnte bei Stromausfall sofort zu Datenverlust und Schäden führen.

- Massenspeicher (HDDs/SSDs): Kontrollieren Sie den Zustand der Festplatten bzw. SSDs. Moderne Festplatten und SSDs liefern SMART-Werte (Self-Monitoring, Analysis and Reporting Technology), die Aufschluss über Fehler und den „Gesundheitszustand" geben. Achten Sie auf Warnzeichen wie ansteigende Reallocated Sectors, hohe Betriebstemperaturen oder bei SSDs einen kritischen Wear-Level (Abnutzungsgrad der Speicherzellen). Solche Indikatoren deuten auf bevorstehende Ausfälle hin. Tauschen Sie verdächtige Laufwerke frühzeitig, bevor sie ausfallen. Bei RAID-Systemen überprüfen Sie den Status aller Arrays und stellen sicher, dass Hot-Spare-Laufwerke vorhanden und einsatzbereit sind.

Untersuchen Sie auch Arbeitsspeicher-Module (Memory) auf Fehler mittels Memory-Tests, insbesondere wenn Logs Speicherfehler verzeichnen. Checken Sie Erweiterungskarten und Verkabelungen auf festen Sitz; ein leicht gelöster Netzwerkadapter oder ein korrodiertes Kabel kann schwer diagnostizierbare Fehler verursachen.

Softwarepflege

Zur Softwarepflege gehört in erster Linie das Installieren von Updates für das Betriebssystem, die Server-Dienste und gegebenenfalls Firmware-Updates der Hardware. Betriebssystem- und Firmware-Updates sollten zeitnah eingespielt werden, sobald sie vom Hersteller als stabil und sicher freigegeben sind. Betriebssystemhersteller veröffentlichen regelmäßig (oft monatlich, z.B. Microsoft Patchday) Updates, die Sicherheitslücken schließen und Fehler beheben. Diese Patches sind kein „Kann", sondern ein absolutes „Muss", um Hackern keine Angriffsfläche zu bieten.

Auch Anwendungssoftware (etwa Datenbank-Server, Webserver, CMS wie WordPress) erfordert kontinuierliche Updates. Neben Sicherheit bringen Updates oft Performance-Verbesserungen oder beheben Stabilitätsprobleme, was dem Serverbetrieb zugutekommt.

In professionellen Umgebungen empfiehlt sich ein strukturiertes Patch-Management. Das bedeutet: Updates zunächst in einer Testumgebung prüfen, bevor sie auf Produktionsserver gespielt werden. So verhindert man, dass fehlerhafte Patches den Dienstbetrieb stören („Never change a running system" gilt hier eingeschränkt – Testen statt blindes Einspielen ist das Motto). Nach erfolgreichem Test sollten Patches jedoch nicht unnötig lange verzögert werden, weil ein Patch-Stau zu einem unsicheren System führt. Automatisierungstools können helfen, Patch-Prozesse effizient zu gestalten. Wichtig ist auch die Reihenfolge: Kritische Sicherheitsupdates haben Vorrang, während optionale Feature-Updates auch mal warten können.

Zusätzlich zu Updates gehört zur Software-Wartung das Aufräumen des Systems: Entfernen Sie nicht mehr benötigte Software, alte Logfiles, temporäre Dateien oder alte Versionen von Anwendungen. Ein aufgeräumtes System hat eine kleinere Angriffsfläche und weniger Ballast. Außerdem beugt das Löschen unnötiger Daten Speicherplatzproblemen vor – vollgelaufene Systempartitionen sind eine häufige Ursache für Serverausfälle. Halten Sie die Server-Software schlank und aktuell, um Stabilität und Sicherheit zu gewährleisten.

Im Rahmen der Wartung sollten auch Neustarts von Diensten oder des gesamten Servers geplant erfolgen (z.B. nach Patches oder um Speicherlecks zu beheben).

Security-Maßnahmen

Serverwartung und IT-Sicherheit gehen Hand in Hand. Im Wartungszyklus müssen daher gezielt Security-Maßnahmen durchgeführt werden:

- Schwachstellenscans: Anstatt nur auf Hersteller-Patches zu warten, sollten Systeme proaktiv mit speziellen Tools auf bekannte Schwachstellen gescannt werden. Dies hilft, Konfigurationsfehler oder vergessene, verwundbare Software zu identifizieren und umgehend zu beheben.

- Zugriffskontrolle und Rechtemanagement: Es muss regelmäßig überprüft werden, wer auf den Server zugreifen darf und welche Berechtigungen die einzelnen Benutzerkonten haben. Hierbei gilt strikt das „Prinzip der geringsten Rechte" (Least Privilege Principle): Jeder Benutzer und jeder Dienst erhält nur die minimalen Berechtigungen, die zur Erfüllung der jeweiligen Aufgabe absolut notwendig sind.

- Schutzsysteme: Die Funktionalität und Aktualität der installierten Sicherheitssysteme müssen gewährleistet sein. Dazu gehört die Überprüfung, ob die Antiviren-Software aktiv ist und ihre Virensignaturen auf dem neuesten Stand sind. Ebenso müssen die Konfigurationen der Firewall regelmäßig kontrolliert werden, um sicherzustellen, dass nur notwendige Verbindungen erlaubt sind.

Monitoring & Logging

Monitoring und Logging sind die Augen und Ohren des Administrators und daher integraler Bestandteil einer guten Serverwartung. Ohne Überwachung kann man Probleme weder frühzeitig erkennen noch effektiv darauf reagieren.

Ein Server sollte permanent auf seine Kernressourcen hin überwacht werden. Typische Metriken und Kennzahlen sind CPU-Auslastung, Arbeitsspeicherverbrauch (RAM), Festplatten- bzw. SSD-Auslastung (Belegung und I/O-Last) sowie Netzwerk-Traffic. Plötzliche Ausschläge oder anhaltend hohe Auslastung können auf Probleme hindeuten wie etwa ein Speicherleck, einen hängenden Prozess oder auch einen laufenden Cyberangriff (z.B. ungewöhnlich hoher Traffic). Monitoring-Tools erfassen diese Werte kontinuierlich und alarmieren bei Überschreiten definierter Schwellwerte. So kann man gegensteuern, bevor Nutzer etwas von der Beeinträchtigung merken.

Neben der Ressourcenauslastung sollte die Erreichbarkeit wichtiger Dienste (Webserver, Datenbank, E-Mail, etc.) überwacht werden. Ein Monitoring-System kann beispielsweise in kurzen Intervallen versuchen, eine Webseite abzurufen oder eine Datenbankabfrage zu stellen. Fällt ein Dienst aus oder reagiert er fehlerhaft, wird sofort Alarm geschlagen. Diese Art von Check (oft „Heartbeat" oder "Health-Check" genannt) garantiert, dass nicht nur die Hardware läuft, sondern auch die angebotenen Services tatsächlich funktionieren.

Server protokollieren kontinuierlich Ereignisse in Logfiles (System-Eventlogs, Anwendungslogs, Sicherheitslogs). Kein Wartungsplan ist vollständig ohne regelmäßige Log-Prüfung. Manuell alle Logs zu lesen, ist jedoch kaum möglich. Deshalb kommen Tools zum Einsatz, die Logs automatisch auswerten. Sie durchsuchen große Log-Mengen nach Fehlern oder verdächtigen Mustern und können bei kritischen Einträgen Benachrichtigungen auslösen. Beispiel: Wenn wiederholt Fehlermeldungen zu einem Speichermodul auftreten, sollte ein Admin informiert werden, da dies auf ein sich anbahnendes Hardwareproblem hindeuten könnte.

Logging hilft auch bei der Fehlerursachenanalyse: Tritt ein Problem auf, liefern historische Logs oft den nötigen Hinweis, wann und warum es dazu kam. Im Sinne der DSGVO und allgemeinen Ordnung sollte zudem ein Log-Retention-Konzept bestehen – also wie lange welche Logs aufbewahrt und wann sie datenschutzkonform gelöscht werden.

Backup & Recovery

Kein Wartungskonzept ist vollständig ohne solide Backup- und Recovery-Strategie. Hardware kann trotz aller Vorsicht ausfallen, Software kann Fehler haben, und menschliche Irrtümer passieren. Dann bewahrt nur ein aktuelles Backup vor Datenverlust und langen Ausfallzeiten.

Die bewährte 3-2-1-Backup-Regel besagt: Halten Sie 3 Kopien Ihrer Daten auf 2 verschiedenen Medientypen, und bewahren Sie 1 Kopie extern/offsite auf (z.B. in der Cloud oder an einem anderen Standort). Im Alltag heißt das: Neben den Produktionsdaten mindestens zwei Backups, z.B. eines lokal auf dem Backup-Server und eines zusätzlich in einem externen Rechenzentrum oder auf Tape, um auch vor Feuer/Diebstahl etc. geschützt zu sein.

Wichtig ist auch, verschiedene Backup-Arten zu kombinieren – etwa regelmäßige Voll-Backups (wöchentlich/monatlich) ergänzt durch inkrementelle Backups (täglich), um einen sinnvollen Kompromiss aus Datenstand und Backup-Größe herzustellen.

Backups sollten automatisiert und regelmäßig erfolgen; bei geschäftskritischen Servern idealerweise täglich (bzw. nächtlich), bei weniger volatilen Daten reichen vielleicht längere Intervalle. Kontrollieren Sie, dass die Backup-Jobs tatsächlich erfolgreich durchlaufen (Backup-Logs täglich prüfen!). Im Wartungsplan kann z.B. stehen: „Jeden Morgen kontrollieren, ob das letzte Nacht-Backup ohne Fehler abgeschlossen wurde".

Zudem müssen Aufbewahrungsfristen definiert sein: Wie lange werden Backups aufgehoben, bevor sie überschrieben werden? (Das hängt auch von rechtlichen Vorgaben ab – Stichwort DSGVO und steuerliche Vorgaben.) Ein guter Backup-Plan enthält auch eine Versionierung: Sie sollten möglichst mehrere Wiederherstellungspunkte in der Vergangenheit haben, um nicht nur den allerletzten Zustand zurückzuholen, sondern z.B. auch den Stand von vor einer Woche (falls ein Fehler längere Zeit unbemerkt blieb).

Entscheidend und leider oft vernachlässigt ist die regelmäßige Überprüfung, ob sich Backups im Notfall tatsächlich wiederherstellen lassen. Ein Backup, das nie testweise zurückgespielt wurde, ist ein unkalkuliertes Risiko. Deshalb: In Ihren Wartungsplan gehören Test-Wiederherstellungen in regelmäßigen Abständen (z.B. wöchentlich einen einzelnen File-Restore testen, und quartalsweise eine komplette Server-Wiederherstellung in einer isolierten Umgebung üben). So stellen Sie sicher, dass die Backup-Daten intakt und lesbar sind und Sie im Ernstfall wissen, wie der Restore-Prozess funktioniert. „Backup ohne Restore-Test = kein Backup" – diesen Merksatz sollten Sie stets im Hinterkopf haben. Nur durch Tests erkennt man Probleme wie defekte Backup-Medien, unvollständige Sicherungskonfigurationen oder zu lange Restore-Dauern rechtzeitig und kann gegensteuern.

Dokumentation

Die Dokumentation ist ein oft ungeliebter, aber essenzieller Teil der Serverwartung. Jede Änderung, jeder Wartungsschritt, jedes aufgetretene Problem sollte nachvollziehbar festgehalten werden. Warum ist das so wichtig? Weil während eines Wartungsfensters meist viele Änderungen am System passieren– seien es Hardwaretausch, Software-Updates oder Anpassungen an der Konfiguration. Ohne sauber festzuhalten, was geändert wurde, ist es später schwierig nachzuvollziehen, wodurch eventuell neue Probleme entstanden sind oder wie der vorherige Zustand war.

Pro Wartungsvorgang (z.B. monatliches Update-Fenster) sollte ein kurzes Protokoll angelegt werden. Darin notiert man Datum/Uhrzeit, die verantwortliche Person, durchgeführte Maßnahmen und Ergebnisse. Auch aufgetretene besondere Vorkommnisse (z.B. ein Update schlug fehl und wurde zurückgerollt) gehören ins Protokoll. Dieses Logbuch der Wartung schafft Transparenz und hilft beim Troubleshooting, falls nach der Wartung Auffälligkeiten auftreten.

Im professionellen Umfeld ist das Änderungsmanagement eng mit der Wartung verzahnt. Jede Änderung an Hardware, Software oder Konfiguration sollte dokumentiert und je nach Kritikalität vorab genehmigt werden. Viele Unternehmen nutzen dafür eine CMDB (Configuration Management Database) oder ähnliche Tools. Wenn z.B. ein Server mehr RAM erhält, ein anderes Betriebssystem-Image bekommt oder neue Benutzerrollen eingerichtet werden, müssen diese Änderungen in der Inventar- und Konfigurationsdokumentation nachgezogen werden. So bleibt der „Single Source of Truth" über die IT-Konfiguration aktuell, was auch für Audits (ISO 27001 etc.) wichtig ist.

Halten Sie Ihre Inventarlisten aktuell. Seriennummern von Hardware, Standort des Servers, installierte Software-Versionen, Lizenzinformationen – all das sollte gepflegt werden. Bei der Wartung kann z.B. auffallen, dass die Firmware einer bestimmten RAID-Controller-Version Probleme macht; dann ist es hilfreich, schnell herauszufinden, auf welchen Servern diese Version noch im Einsatz ist. Gute Dokumentation ermöglicht solche Abfragen.

Aktualisieren Sie nach Wartungsarbeiten auch alle sicherheitsrelevanten Dokumente. Dazu gehört z.B. bei Änderungen an Firewall-Regeln die Anpassung der Netzwerk-Dokumentation oder nach dem Entfernen von Benutzerkonten die Anpassung von Berechtigungsübersichten. Auch Passwörter für Geräte oder Admin-Accounts, die turnusmäßig geändert wurden, müssen an zentraler Stelle (z.B. im Passwort-Tresor oder Dokument) erneuert werden.

Sollten im Wartungszeitraum neue Backup-Lösungen eingerichtet oder Pfade geändert worden sein, passen Sie umgehend die Disaster-Recovery-Dokumentation an. Es darf im Ernstfall kein Zweifel bestehen, welche Daten wo gesichert sind und wie sie zurückgespielt werden. Ebenso gehören neue Erkenntnisse (z.B. aus einer Test-Wiederherstellung) in die Doku, um den Notfallplan zu verbessern.

Ihr Wartungsspezialist im DataCenter

Durch Jahrzehnte lange Erfahrung wissen wir worauf es in Ihrem Data Center ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Geplante Downtimes vs. Live-Wartung

Viele Wartungsarbeiten, insbesondere das Einspielen von Firmware- oder kritischen Betriebssystem-Updates, erfordern einen Neustart des Servers. Um die Auswirkungen auf den Geschäftsbetrieb zu minimieren, müssen diese Arbeiten in geplanten Wartungsfenstern stattfinden, typischerweise nachts oder am Wochenende. Diese geplanten Ausfallzeiten müssen frühzeitig kommuniziert werden.

Es ist wichtig, solche Downtimes rechtzeitig zu planen und zu kommunizieren. Anwender oder Kunden sollten früh informiert werden, wann und wie lange ein Service nicht verfügbar ist.

In hochverfügbaren Umgebungen mit redundanten Systemen kann eine Live-Wartung durchgeführt werden. Hierbei wird ein Server des Clusters aus dem Verbund genommen und gewartet, während der andere den Betrieb nahtlos aufrechterhält. Nach Abschluss der Wartung wird der erste Server wieder in den Cluster integriert und der Prozess für den zweiten Server wiederholt, wodurch eine Wartung ohne spürbare Downtime für die Benutzer möglich wird.

Auch Clustering und Load-Balancing sind Strategien, um Wartung ohne Downtime zu ermöglichen. In einem Web-Cluster kann man einen Knoten nach dem anderen vom Load-Balancer nehmen, updaten und danach wieder zuschalten, während die anderen Knoten den Traffic übernehmen. Datenbank-Clustering erlaubt die Wartung des Secondary-Servers, dann ein Failover, dann Wartung des bisherigen Primary usw. So bleibt der Dienst insgesamt verfügbar.

Wo solche Lösungen nicht möglich sind, muss man die unvermeidlichen Downtimes möglichst kurz und effizient halten. Das gelingt durch gute Vorbereitung: alle benötigten Patches/Dateien vorab herunterladen, Schritte proben (ggf. in einer Testumgebung), und einen detaillierten Ablaufplan schreiben. So wird keine Zeit verschwendet, wenn der Server offline ist. Zudem sollte man immer einen Rollback-Plan bereithalten: Was tun, wenn z.B. ein Update fehlschlägt? Im besten Fall kann man dann schnell auf den vorherigen Stand zurück, um die Downtime nicht zu verlängern.

Werkzeuge und Hilfsmittel

Die manuelle Wartung von Servern ist zeitaufwendig und fehleranfällig. Moderne Werkzeuge helfen, Prozesse zu automatisieren, den Überblick zu behalten und die Effizienz drastisch zu steigern.

Automatisierung

Automatisierung ist der wichtigste Hebel, um eine konsistente und zuverlässige Wartung zu gewährleisten. Sie reduziert den manuellen Aufwand, minimiert das Risiko menschlicher Fehler und sorgt dafür, dass Aufgaben reproduzierbar und nachvollziehbar ausgeführt werden.

Besonders in Linux-Umgebungen hat sich Ansible als Standard für die Automatisierung etabliert. Mit einfachen, textbasierten „Playbooks" können Administratoren komplexe Aufgaben wie das Patchen von hunderten Servern, die Installation von Software oder die Änderung von Konfigurationen mit einem einzigen Befehl ausführen. Das stellt sicher, dass alle Systeme identisch konfiguriert sind und keine manuellen Abweichungen entstehen.

Für spezifische oder einfachere Aufgaben sind die nativen Skriptsprachen der Betriebssysteme oft ausreichend. Mit PowerShell (Windows) und Bash-Skripten (Linux) lassen sich wiederkehrende Aufgaben wie das Bereinigen von Log-Dateien oder das Überprüfen von Diensten einfach automatisieren.

Die Wahl der richtigen Monitoring-Tools

Eine lückenlose Überwachung ist die Voraussetzung für proaktives Handeln. Der Markt bietet eine breite Palette an Werkzeugen, die sich grob in Open-Source- und kommerzielle Lösungen unterteilen lassen.

Open-Source-Lösungen

Werkzeuge wie Prometheus, Grafana, Nagios oder Zabbix sind extrem leistungsfähig, flexibel und in der Anschaffung kostenlos. Sie erfordern jedoch ein hohes Maß an technischem Know-how für die Einrichtung, Konfiguration und den laufenden Betrieb. Sie sind ideal für Unternehmen mit einer starken internen IT-Abteilung, die eine maßgeschneiderte Lösung aufbauen möchte.

Die folgende Tabelle vergleicht einige populäre Open-Source-Tools, um eine Entscheidungsgrundlage für technisch versierte Unternehmen zu bieten:

| Tool | Stärken | Schwächen | Ideal für… |

| Prometheus & Grafana | Exzellent für dynamische Cloud- & Container-Umgebungen (Kubernetes). Mächtige Abfragesprache (PromQL). Sehr flexible Dashboards (Grafana). | Steile Lernkurve. Fokus auf Metriken (Pull-Modell), weniger auf Event-Handling. Hoher Einrichtungs- und Wartungsaufwand. | DevOps-Teams und Unternehmen mit modernen, microservice-basierten Architekturen, die eine hohe Anpassbarkeit benötigen. |

| Nagios | Sehr ausgereift und stabil mit riesiger Community und tausenden von Plugins. Stark im Event-Handling und bei der Alarmierung. | Veraltete Konfiguration (Textdateien). Weboberfläche nicht mehr zeitgemäß. Weniger geeignet für hochdynamische Umgebungen. | IT-Operations-Teams in traditionelleren Umgebungen (physische/virtuelle Server), die eine zuverlässige Statusüberwachung und Alarmierung für eine breite Palette von Geräten benötigen. |

| Zabbix | All-in-One-Lösung (Monitoring, Alerting, Dashboards). Einfachere Einrichtung als Nagios. Gute Auto-Discovery-Funktionen. | Weniger flexibel als Prometheus in Cloud-nativen Umgebungen. Kann bei sehr großen Installationen komplex werden. | Kleine bis mittelständische Unternehmen, die eine umfassende und integrierte Monitoring-Lösung mit einer modernen Oberfläche suchen, ohne auf mehrere separate Tools setzen zu wollen. |

Kommerzielle Lösungen

Anbieter wie Datadog, Dynatrace oder Sematext bieten Monitoring als Software as a Service (SaaS) an. Diese Tools sind in der Regel einfacher einzurichten, bieten einen professionellen Support und integrieren oft mehrere Funktionen (Metriken, Logs, Tracing) in einer einzigen Plattform. Dafür fallen regelmäßige Lizenz- oder Nutzungsgebühren an.

Best Practices bei der Serverwartung

Über einzelne Aufgaben und Werkzeuge hinaus gibt es grundlegende Prinzipien, deren Einhaltung eine IT-Infrastruktur zu einer robusten und widerstandsfähigen Umgebung macht.

Change-Management und Dokumentationspflicht

Keine Änderung an einem produktiven Server sollte spontan oder undokumentiert erfolgen. Ein formalisierter Change-Management-Prozess stellt sicher, dass jede Änderung, sei es ein Patch, eine Konfigurationsanpassung oder ein Hardware-Upgrade, geplant, auf ihre potenziellen Auswirkungen analysiert, genehmigt, in einer Testumgebung erprobt und nach der Umsetzung dokumentiert wird. Das verhindert „hausgemachte" Ausfälle durch unüberlegte Eingriffe und sorgt für Nachvollziehbarkeit.

Least-Privilege-Prinzip & Segregation of Duties

Diese beiden Sicherheitsprinzipien sind fundamental für die Reduzierung von Risiken.

- Least-Privilege-Prinzip (PoLP): Jeder Benutzer, jeder Dienst und jede Anwendung sollte nur über die minimalen Berechtigungen verfügen, die zur Erfüllung der zugewiesenen Aufgabe zwingend erforderlich sind. Ein Backup-Dienst benötigt beispielsweise keine Administratorrechte auf dem gesamten System. Dieses Prinzip reduziert die Angriffsfläche drastisch: Selbst wenn ein Konto oder eine Anwendung kompromittiert wird, ist der Schaden, den ein Angreifer anrichten kann, stark begrenzt.

- Segregation of Duties (Funktionstrennung): Kritische Aufgaben sollten auf mehrere Personen verteilt werden, um Missbrauch oder Fehler zu verhindern. Beispielsweise sollte die Person, die eine Änderung beantragt und genehmigt, nicht dieselbe sein, die sie technisch umsetzt. Dies schafft ein Vier-Augen-Prinzip und erhöht die Prozesssicherheit.

Redundanz, Failover und die unverzichtbare Testumgebung

Dieses Trio bildet die technische Grundlage für Hochverfügbarkeit und sichere Wartung.

- Redundanz bedeutet, kritische Systemkomponenten mehrfach vorzuhalten. Beispiele sind Server mit zwei Netzteilen, der Einsatz von RAID-Systemen (bei denen eine Festplatte ausfallen kann, ohne dass Daten verloren gehen) oder der Betrieb von zwei identischen Servern in einem Cluster.

- Failover ist der automatische Prozess, der beim Ausfall einer Komponente auf die redundante Komponente umschaltet. Fällt beispielsweise der primäre Server in einem Cluster aus, erkennt das System dies und leitet den gesamten Datenverkehr ohne manuellen Eingriff auf den zweiten Server um, wodurch der Dienst für die Benutzer verfügbar bleibt.

- Testumgebung: Eine der wichtigsten, aber oft aus Kostengründen vernachlässigten Komponenten. Eine Test- oder Staging-Umgebung ist eine exakte Kopie des Produktivsystems, die aber vollständig isoliert ist. Alle Patches, Updates und größeren Konfigurationsänderungen müssen zuerst in dieser Umgebung ausgerollt und auf Herz und Nieren geprüft werden. Nur wenn hier keine Probleme auftreten, darf die Änderung auf das Live-System übertragen werden. Dies ist die einzige Möglichkeit, Patch-bedingte Ausfälle zuverlässig zu verhindern.

Die konsequente Umsetzung dieser drei Best Practices – Change Management, Least Privilege und Redundanz – hebt eine IT-Abteilung von einem reaktiven „Feuerwehr-Modus" auf eine strategische, risikobewusste und proaktive Ebene. Das erhöht nicht nur die Systemstabilität, sondern wird auch von Auditoren im Rahmen von Zertifizierungen (z.B. ISO 27001) und von Cyber-Versicherungen positiv bewertet. Sie sind der Beweis für eine gut geführte und kontrollierte IT-Governance.

Eigenbetrieb, Managed Service oder Hybrid?

Die Frage, wer die Wartung durchführt, ist für viele Unternehmen zentral. Es gibt drei grundlegende Modelle:

- Eigenbetrieb (In-house): Das Unternehmen beschäftigt eigene IT-Administratoren, die die Wartung durchführen. Dies bietet maximale Kontrolle und internes Know-how, bindet aber Personalressourcen und erfordert kontinuierliche Weiterbildung.

- Managed Service (Externer Dienstleister): Die gesamte Serverwartung wird an einen spezialisierten Anbieter ausgelagert. Dies schafft planbare, monatliche Kosten (OpEx), garantiert den Zugriff auf Expertenwissen und entlastet das interne Personal, das sich auf das Kerngeschäft konzentrieren kann. Im Gegenzug gibt das Unternehmen einen Teil der direkten Kontrolle ab.

- Hybrid-Modell: Eine Kombination aus beidem. Das interne Team kümmert sich um die täglichen Routineaufgaben, während ein externer Dienstleister für spezielle Projekte, Notfälle oder als Urlaubsvertretung bereitsteht.

Die folgende Tabelle hilft bei der strategischen Entscheidung:

| Aspekt | Eigenbetrieb (In-house) | Managed Service (Extern) |

| Kostenstruktur | Hohe Personalkosten (Fixkosten), Investitionen in Tools | Planbare monatliche Betriebskosten (OpEx) |

| Kontrolle | Maximal, direkte Steuerung | Geringer, abhängig vom Vertrag (SLA) |

| Expertise | Auf internes Personal beschränkt, erfordert ständige Schulung | Zugriff auf ein Team von Spezialisten, breiteres Wissen |

| Verfügbarkeit | Limitiert durch Arbeitszeiten, Urlaub, Krankheit | Oft 24/7-Support garantiert |

| Skalierbarkeit | Langsam, erfordert Neueinstellungen | Schnell, Dienstleister hat Ressourcen |

| Fokus des Teams | IT-Team ist mit Administration beschäftigt | Internes Personal kann sich auf strategische Projekte konzentrieren |

Für die meisten kleinen und mittleren Unternehmen ohne große, spezialisierte IT-Abteilung ist ein Managed Service oder ein Hybrid-Modell oft die wirtschaftlich und operativ sinnvollere Lösung.

Häufige Fragen zur Serverwartung (FAQ)

Was ist Serverwartung?

Serverwartung umfasst alle proaktiven und reaktiven Maßnahmen, um die Zuverlässigkeit, Leistung und Sicherheit von Server-Hardware und -Software zu gewährleisten. Dazu gehören regelmäßige Überprüfungen, Updates, Backups und die Überwachung der Systemgesundheit.

Warum ist Serverwartung so wichtig?

Serverwartung ist entscheidend, um kostspielige Geschäftsausfälle, Datenverluste und Sicherheitsverletzungen zu verhindern. Regelmäßige Wartung sichert die Stabilität der IT-Infrastruktur, die das Rückgrat der meisten modernen Unternehmen bildet.

Wie oft sollte man einen Server warten?

Die Wartungsfrequenz hängt vom Alter und der Kritikalität des Servers ab; eine pauschale Regel gibt es nicht. Tägliche Aufgaben umfassen die Prüfung von Backups und Logs, wöchentliche oder monatliche Aufgaben wie das Einspielen von Patches, während Hardware-Inspektionen quartalsweise oder jährlich erfolgen sollten.

Kann man Serverwartung selbst durchführen?

Ja, sofern das notwendige Fachwissen und die zeitlichen Ressourcen intern vorhanden sind, ist eine Eigenverwaltung möglich. Für viele Unternehmen, insbesondere ohne dedizierte IT-Abteilung, ist die Auslagerung an einen spezialisierten Dienstleister jedoch sicherer und oft kosteneffizienter.

Sollte man die Serverwartung intern durchführen oder an einen externen Dienstleister vergeben?

Das hängt von den verfügbaren Ressourcen und dem Know-how ab. Interne Serverwartung bietet volle Kontrolle und unmittelbare Verfügbarkeit, setzt aber erfahrenes Personal voraus (und Ausfallsicherheit bei Urlaub/Krankheit). Externe Dienstleister (Managed Services) bringen Expertise mit und bieten oft 24/7-Betreuung – für Firmen ohne eigenes IT-Team ist das meist effizienter und unterm Strich manchmal günstiger. Viele Unternehmen wählen einen Hybridweg: Standard-Wartung durch Dienstleister (Updates, Monitoring) und unternehmensspezifische Aufgaben intern. Wichtig ist, dass Wartung überhaupt passiert – ob intern oder extern, sollte pragmatisch nach Kosten/Nutzen entschieden werden.

Was ist der Unterschied zwischen Hardware- und Softwarewartung?

Hardwarewartung betrifft die physischen Komponenten wie Lüfter, Festplatten und Stromversorgung, um deren Funktionsfähigkeit sicherzustellen. Softwarewartung konzentriert sich auf das Betriebssystem und die Anwendungen, um durch Updates und Patches Sicherheitslücken zu schließen und die Leistung zu optimieren.

Was ist in einem Wartungsvertrag enthalten?

Ein guter Wartungsvertrag definiert klar den Leistungsumfang, garantierte Reaktions- und Lösungszeiten (SLAs), Kosten und die abgedeckten Systeme. Er sollte typischerweise regelmäßige Updates, Monitoring, Backup-Management und Support bei Störungen umfassen.

Was bedeutet „Managed Server" im Kontext der Wartung?

Bei einem Managed Server übernimmt der Hosting-Anbieter die komplette Administration, Wartung und Überwachung des Servers. Der Kunde muss sich nicht um technische Details wie Betriebssystem-Updates, Sicherheitspatches oder Hardware-Monitoring kümmern und kann sich auf sein Kerngeschäft konzentrieren.

Was ist der Unterschied zwischen proaktiver und reaktiver Wartung?

Proaktive Wartung bedeutet, vorausschauend Maßnahmen zu ergreifen, bevor ein Problem auftritt – also regelmäßige Inspektion, vorbeugende Komponententausche (z.B. Festplatte tauschen bei ersten SMART-Fehlern), kontinuierliches Patchen etc. Reaktive Wartung heißt, man wird erst tätig, wenn etwas kaputt geht oder ausfällt. Proaktiv sorgt für planbare kurze Wartungszeit, reaktiv führt oft zu längeren, unplanbaren Ausfällen. Im Ergebnis ist proaktive Wartung deutlich effizienter und kostengünstiger, da sie teure Betriebsunterbrechungen minimiert. Moderne IT-Strategie setzt daher klar auf Proaktivität: Es ist besser, in kleinen Dosen kontinuierlich zu pflegen, als große Störungen im Nachhinein reparieren zu müssen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Google Gemini 3.1 Pro ist da: Spitzenreiter in vielen Benchmarks

Mit Gemini 3.1 Pro präsentiert Google die nächste Generation seiner Gemini-Modellreihe, die als das bisher fortschrittlichste Modell des Unternehmens für

Von OpenClaw zu OpenAI: Warum Europa seine KI-Talente verliert – Plus: 5 neue China-Modelle im Check

️ Über diese Episode Peter Steinbergers Wechsel von OpenClaw zu OpenAI ist mehr als eine Personalentscheidung – es

KI-Pakt zwischen Deutschland und Indien beschlossen

Deutschland und Indien haben ihre strategische Partnerschaft auf eine neue Ebene gehoben. Am Rande des AI Impact Summit in Neu-Delhi

Zum Inhalt springen

Zum Inhalt springen