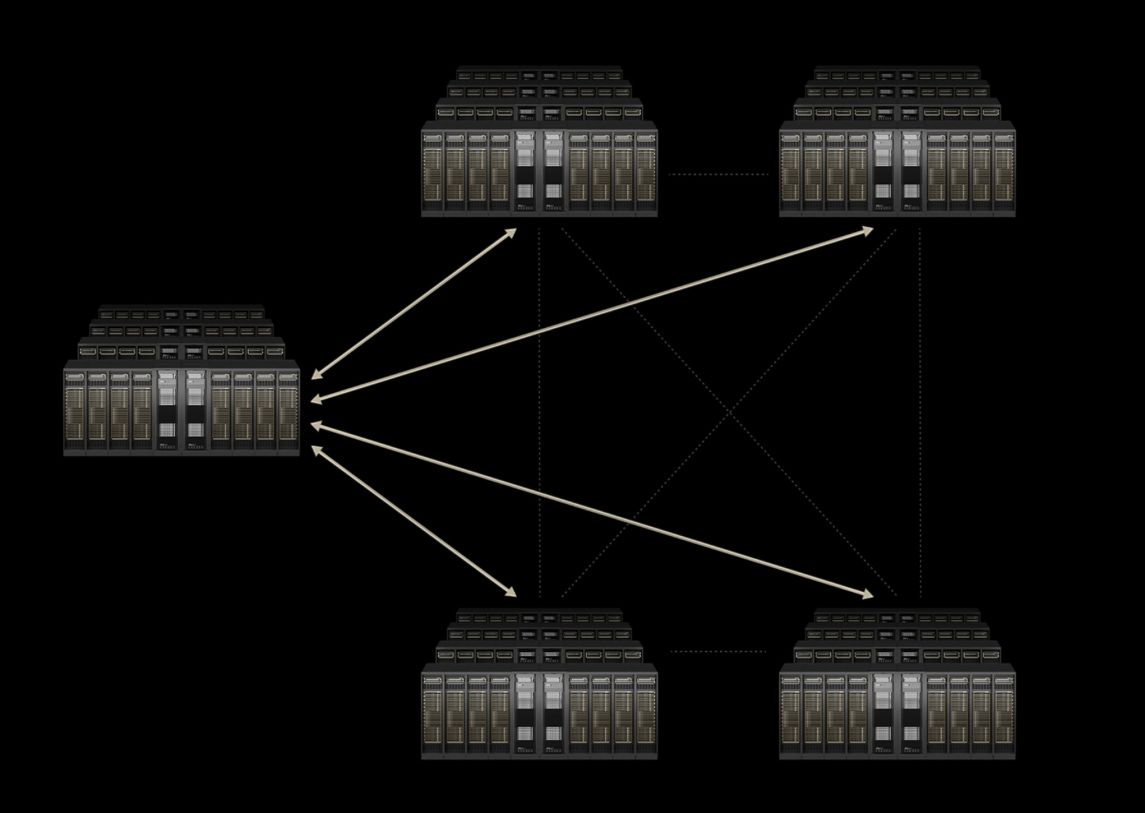

Nvidia hat eine neue Scale-Across-Technologie vorgestellt: Spectrum-XGS Ethernet. Ziel dieser Entwicklung ist es, mehrere Rechenzentren miteinander zu verbinden, um eine vereinheitlichte „KI-Superfabrik" zu bilden. Nvidia präsentierte Spectrum-XGS auf der Hot Chips 2025 als eine Lösung für den steigenden Ressourcenbedarf aufgrund von KI.

Laut Dave Salvator, Director of Accelerated Computing Products bei Nvidias Accelerated Computing Group übersteige die zunehmende Inferenzleistung von KI-Agenten normale Aufgaben für Multi-GPU- und Multi-Node-Systeme und werde damit zu einer Herausforderung für die Skalierung von Netzwerken.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Spectrum-XGS baut auf Spectrum-X auf, Nvidias Ethernet-basierter Netzwerkstruktur, die speziell für KI entwickelt wurde. Spectrum-X wurde 2024 eingeführt und vereint Nvidias Netzwerk-Hardware und -Software zu einer KI-optimierten Plattform, die Spectrum SN5600 Switches mit BlueField-3 DPUs kombiniert, um die Netzwerkleistung für generative KI auf das 1,6-fache herkömmlicher Ethernet-Strukturen zu steigern.

Spectrum-XGS markiert die nächste Entwicklungsstufe des Ethernet-Angebots von Nvidia. Mithilfe eines neuen Netzwerkalgorithmus wird die Spectrum-X Infrastruktur genutzt, um Daten effektiv über längere Distanzen zwischen Standorten zu übertragen. Die Lösung integriert Nvidia Spectrum-X Switches mit ConnectX-8 SuperNICs, den KI-zentrierten 800-Gb/s-Netzwerkadaptern des Unternehmens.

Die neue Netzwerkplattform soll die Leistung der Nvidia Collective Communications Library (NCCL) für eine schnelle Kommunikation zwischen Nvidia GPUs nahezu verdoppeln. Die Plattform soll außerdem eine 1,6-fache Bandbreite im Vergleich zu Standard-Ethernet in großen KI-Umgebungen mit mehreren Mietern bieten. Ziel ist es, dass mehrere Rechenzentren miteinander kommunizieren und wie eine mächtige und besonders leistungsfähige GPU oder eine "KI-Superfabrik" (gemäß Nvidias Terminologie) agieren. Die Methode wird als „Scale-Across" beschrieben, ergänzend zu den bestehenden Scale-Up- und Scale-Out-Architekturen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Weitere Artikel

Von OpenClaw zu OpenAI: Warum Europa seine KI-Talente verliert – Plus: 5 neue China-Modelle im Check

️ Über diese Episode Peter Steinbergers Wechsel von OpenClaw zu OpenAI ist mehr als eine Personalentscheidung – es

KI-Pakt zwischen Deutschland und Indien beschlossen

Deutschland und Indien haben ihre strategische Partnerschaft auf eine neue Ebene gehoben. Am Rande des AI Impact Summit in Neu-Delhi

KI-Fortschritt: Der Fall Peter Steinberger zeigt Europas Schwächen gegenüber den USA

Der Wechsel von Peter Steinberger, dem Gründer von OpenClaw, zu OpenAI demonstriert auf drastische Weise, woran es am Wirtschafts- und

Zum Inhalt springen

Zum Inhalt springen