Mistral AI hat Mistral 3 vorgestellt: eine neue Generation offener, multimodaler und mehrsprachiger KI-Modelle. Das Release umfasst drei kleine Modelle mit 14, acht und drei Milliarden Parametern sowie Mistral Large 3, das bisher leistungsfähigste Modell des Unternehmens. Alle Modelle werden unter der Apache-2.0-Lizenz veröffentlicht.

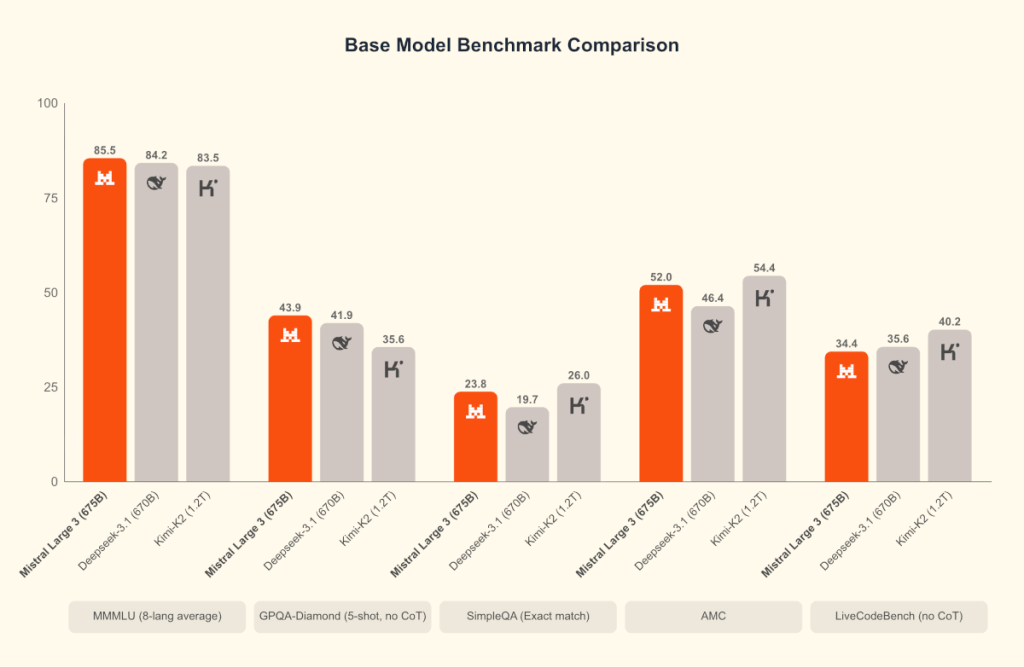

Mistral Large 3 ist ein „Sparse Mixture-of-Experts"-Modell (MoE), das mit 41 Milliarden aktiven und insgesamt 675 Milliarden Parametern arbeitet. Es wurde von Grund auf unter Einsatz von 3000 NVIDIA H200 GPUs trainiert. Nach dem Post-Training ist das Modell gleichauf mit führenden Open-Weight-Modellen bei allgemeinen Prompts und verfügt über Bildverständnis sowie Fähigkeiten in mehrsprachigen Konversationen.

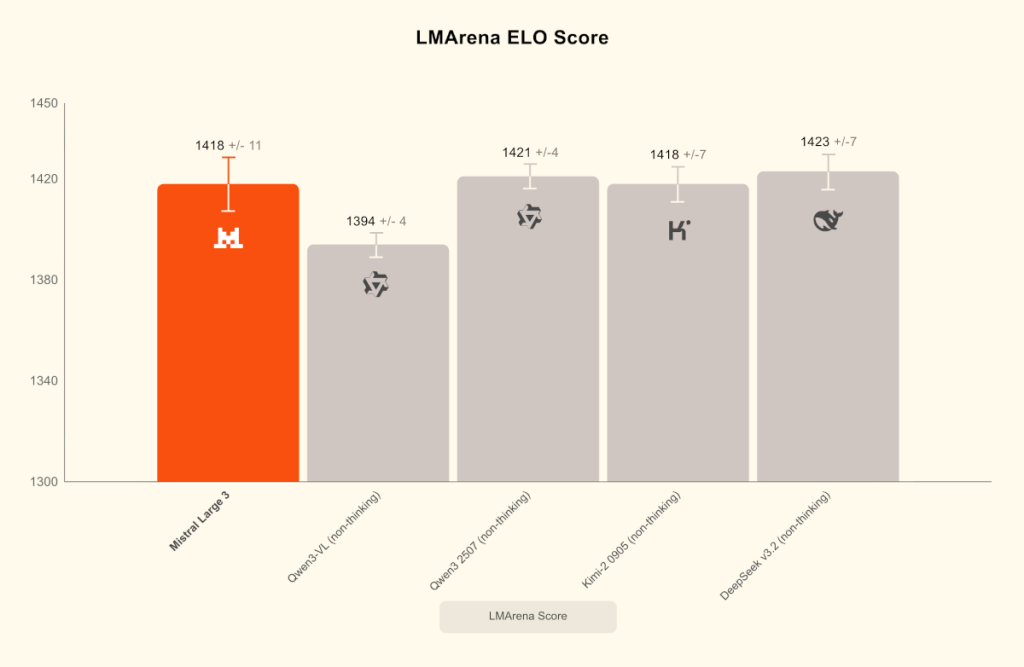

Auf dem LMArena-Leaderboard belegt das Modell Platz zwei in der Kategorie der Open-Source-Modelle ohne Reasoning-Fokus. Es sind sowohl Basis- als auch instruktionsoptimierte Versionen verfügbar, eine Reasoning-Variante soll folgen.

Ministral 3 für lokale Anwendungen

Für lokale Anwendungen und Edge-Szenarien wurde die Ministral-3-Serie eingeführt. Das Angebot besteht aus Modellen in den Größen 3B, 8B und 14B. Für jede dieser Größen gibt es Varianten für Basis-Anwendungen, Instruktionen und Reasoning, die alle über Bildverständnis verfügen.

Die Reasoning-Varianten zielen auf höhere Genauigkeit ab; so erreichte die 14B-Variante 85 Prozent beim AIME '25. Die Ministral-Modelle wurden zudem für Hardware wie DGX Spark, RTX-PCs und Jetson-Geräte optimiert.

Die Entwicklung erfolgte in Zusammenarbeit mit Partnern wie NVIDIA, vLLM und Red Hat. Um die Effizienz zu steigern, wurde ein Checkpoint im NVFP4-Format veröffentlicht, der die Ausführung auf Systemen wie Blackwell NVL72 oder einzelnen NVIDIA-Knoten ermöglicht. NVIDIA unterstützte zudem die Integration von Inferenz-Support für TensorRT-LLM und SGLang.

Die Modelle sind ab sofort über verschiedene Plattformen verfügbar, darunter Mistral AI Studio, Amazon Bedrock, Azure Foundry und Hugging Face. Zusätzlich bietet Mistral AI Dienste für das Training kundenspezifischer Modelle an, um Anpassungen an spezifische Datensätze oder Aufgaben vorzunehmen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Beschädigung des Peace-Unterseekabels im Roten Meer: erhebliche Störung des globalen Datenverkehrs erwartet

Das Peace Unterseekabel im Roten Meer wurde beschädigt. Die Folgen sind voraussichtlich monatelange Reparaturen und erhebliche Auswirkungen auf den

Project Stargate: 64.000 Nvidia GB200 GPUs werden in texanischem Rechenzentrum installiert

Das Project Stargate nimmt Fahrt auf: Die geplante Installation von 64.000 hochmodernen Nvidia GB200 Grafikprozessoren im Stargate Rechenzentrum in

Microsoft investiert in indische Aufforstung: 1,5 Millionen Tonnen CO2-Entnahme über 30 Jahre

Microsoft beteiligt sich an einem Aufforstungsprojekt in Indien und will damit eine CO2-Entnahme von 1,5 Millionen Tonnen in 30

Zum Inhalt springen

Zum Inhalt springen