TL;DR: das Wichtigste in Kürze

- Klassischen Large Language Models (LLMs) wie GPT-5.2 oder Claude fehlt ein wichtiges Element wahrer Intelligenz: ein verankertes Verständnis der physischen Realität und ihrer Kausalitäten.

- Führende KI-Forscher argumentieren, dass der Weg zur Artificial General Intelligence (AGI) über die Implementierung sogenannter World Models führen muss.

- Ein World Model ist eine interne, oft neuronale Repräsentation der Außenwelt, die es einem KI-Agenten ermöglicht, die Konsequenzen seiner Handlungen mental zu simulieren, bevor er sie in der Realität ausführt.

- Die Anwendungsfelder reichen von autonomen Fahrzeugen über Roboter bis hin zu Virtual Cells in der Biologie, welche die Reaktion von Zellen auf Medikamente simulieren.

Das fehlende Puzzlestück der Intelligenz

Wenn ein Mensch einen Ball fängt, führt er keine bewussten Berechnungen durch. Dennoch bewegt sich die Hand präzise dorthin, wo der Ball sein wird, und nicht dorthin, wo er im Moment der Wahrnehmung war. Dieses Phänomen, das in der Kognitionswissenschaft und Neurowissenschaft gut untersucht ist, basiert auf der Fähigkeit des Gehirns, kontinuierlich die Zukunft zu projizieren. Das Gehirn ist keine passive Empfangsstation für Sinnesdaten, sondern eine proaktive Vorhersagemaschine – eine Predictive Processing Engine. Wir besitzen ein internes Modell der Welt, das uns sagt, dass Tassen fallen, wenn man sie loslässt, und dass verdeckte Objekte nicht aufhören zu existieren.

In der Geschichte der künstlichen Intelligenz dominierte lange Zeit ein anderer Ansatz. Insbesondere im Bereich des Reinforcement Learning verließen sich Forscher auf sogenannte Model-Free-Methoden. Ein Agent – sei es ein Roboter oder ein virtueller Charakter – lernte durch bloßes Ausprobieren, welche Aktion in welchem Zustand die höchste Belohnung versprach. Diese Systeme entwickelten komplexe Verhaltensweisen, waren aber im Kern reaktiv: Siehe X, mache Y. Sie verstanden nicht, warum eine Aktion zum Erfolg führte, sondern nur, dass sie statistisch korreliert war.

Das Konzept der World Models bricht mit dieser Tradition und versucht, die menschliche Fähigkeit zur mentalen Simulation technisch nachzubilden. Es ist der Versuch, der KI eine Art von Vorstellungskraft zu geben. Diese Fähigkeit ist eine Notwendigkeit für die nächste Stufe der Automatisierung. Ein autonomes Fahrzeug kann nicht ausprobieren, was passiert, wenn es bei Rot über die Ampel fährt, um zu lernen, dass das schlecht ist. Es muss in der Lage sein, diese Situation intern zu simulieren und das Ergebnis vorherzusehen, ohne es physisch zu erleben.

Die Relevanz in der Ära der Generativen KI

Large Language Models (LLMs) erzeugen Sprache auf einem Niveau, das von menschlicher Kommunikation kaum zu unterscheiden ist. Doch trotz ihrer Eloquenz stoßen diese Modelle an harte Grenzen, wenn es um das Verständnis der physischen Realität, logische Konsistenz über lange Zeiträume oder das Planen komplexer Handlungssequenzen in dynamischen Umgebungen geht.

World Models werden von führenden Wissenschaftlern als die Antwort auf diese Einschränkungen gesehen. Yann LeCun, einer der Väter des Deep Learning und ehemaliger Chief AI Scientist bei Meta, der inzwischen ein Startup mit dem Namen Advanced Machine Intelligence (AMI) mitgegründet hat, vertritt die Meinung, dass LLMs eine Sackgasse auf dem Weg zu AGI sein könnten, wenn sie nicht durch Systeme ergänzt werden, die in der physischen Realität begründet sind. Während ein LLM die statistische Wahrscheinlichkeit des Wortes "Glas" nach dem Wort "zerbrochen" kennt, weiß ein World Model, welche physikalischen Kräfte wirken müssen, um diesen Zustand herbeizuführen, und wie die Scherben verteilt sein würden.

Definition: Was ist ein World Model?

Um ein World Model zu verstehen, muss man es als eine Funktion betrachten, die den Zustand der Welt fortschreibt. Sei St der Zustand der Welt zum Zeitpunkt t und At eine Aktion, die ein Agent ausführt. Ein World Model M versucht, die Wahrscheinlichkeitsverteilung des nächsten Zustands St+1 vorherzusagen:

P(St+1 | At, St)

Diese scheinbar einfache Formel birgt immense Komplexität. Die Welt ist in der Regel nur teilweise beobachtbar, scheinbar zufällig und hochdimensional. Ein effektives World Model muss daher drei Kernfähigkeiten besitzen:

- Abstraktion (Kompressionsfähigkeit): Es darf nicht versuchen, die Welt Pixel für Pixel zu speichern. Stattdessen muss es sensorische Rohdaten in kompakte, latente Zustände übersetzen, die nur die relevanten Informationen enthalten.

- Temporale Dynamik (Zeitverständnis): Es muss lernen, wie sich diese Zustände über die Zeit verändern, sowohl natürlich als auch durch Einwirkung des Agenten.

- Kausalität (Ursache-Wirkung-Verständnis): Es muss verstehen, dass At die Ursache für die Änderung zu St+1 ist.

Die Kernkomponenten der Architektur

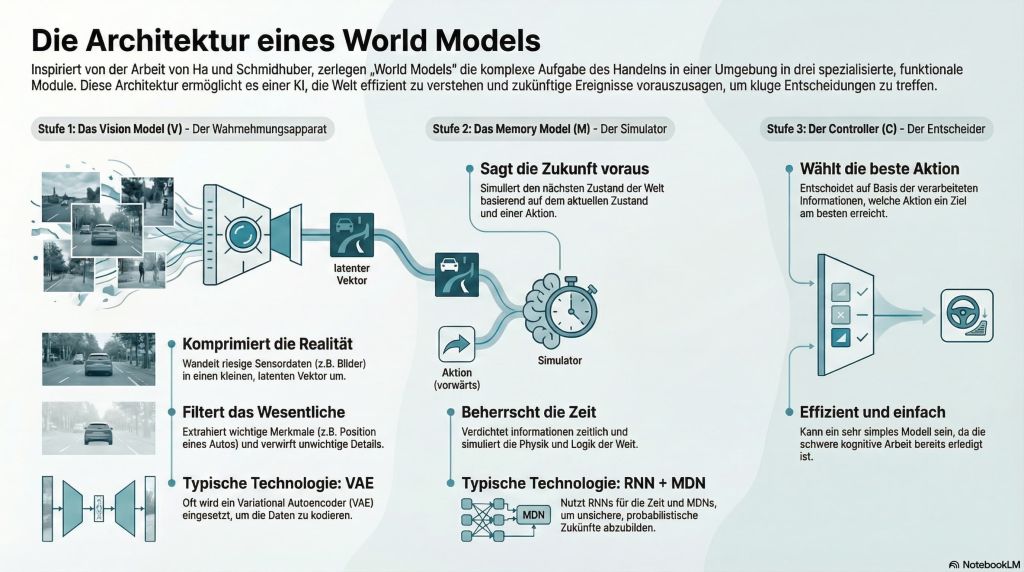

Basierend auf der wegweisenden Arbeit "World Models" von David Ha und Jürgen Schmidhuber (2018), die oft als Referenzarchitektur dient, lässt sich ein solches System in drei funktionale Module zerlegen:

Das Vision Model (V): der Wahrnehmungsapparat

Die erste Hürde für jede KI ist die Verarbeitung der enormen Datenflut der Sensoren. Ein einzelnes Bild einer HD-Kamera enthält Millionen von Werten. Würde man versuchen, auf dieser Ebene zu planen, würde das System an der Datenmenge ersticken (Curse of Dimensionality).

Das Vision Model (V) fungiert als Kompressor. Technisch wird hier oft ein sogenannter Variational Autoencoder (VAE) eingesetzt. Dieser lernt, ein Eingangsbild in einen Vektor zu kodieren. Dieser Vektor ist winzig im Vergleich zum Bild (z. B. 32 oder 64 Zahlen statt Millionen). Der VAE wird trainiert, indem er gezwungen wird, aus diesem winzigen Vektor das Originalbild wiederherzustellen.

Um das Bild erfolgreich zu rekonstruieren, muss der Vektor die essentiellen Eigenschaften der Szene speichern: Wo ist das Auto? Wie ist der Straßenverlauf? Wo ist das Hindernis? Unwichtige Details wie das Rauschen der Textur auf dem Asphalt werden oft verworfen. Der VAE filtert die Realität und extrahiert ihre Struktur.

Das Memory Model (M): der Simulator

Das Memory Model ist das Herzstück des World Models. Während das Vision Model räumlich komprimiert, komprimiert das Memory Model zeitlich. Es sagt voraus, was als Nächstes passiert.

Technisch wird hier oft ein Recurrent Neural Network (RNN), genauer gesagt oft ein LSTM (Long Short-Term Memory) oder in neueren Iterationen ein Transformer verwendet. In der Arbeit von Ha und Schmidhuber wurde dies mit einem Mixture Density Network (MDN) kombiniert.

- Warum MDN? Die Zukunft ist nicht deterministisch. Wenn man in einem Spiel einem Gegner gegenübersteht, kann dieser nach links oder rechts ausweichen. Ein einfaches Modell, das den Durchschnitt aller Möglichkeiten vorhersagt, würde vorhersagen, dass der Gegner sich teilt oder in der Mitte stehen bleibt – beides falsch. Ein MDN sagt stattdessen eine Wahrscheinlichkeitsverteilung voraus (z. B. zu 60 % links, zu 40 % rechts).

- Aufgabe: Das RNN nimmt den aktuellen latenten Zustand sowie eine Aktion und liefert den sich daraus ergebenden Zustand. Es simuliert die Physik und Logik der Welt im komprimierten Raum.

Der Controller (C): der Entscheider

Der Controller ist die Instanz, die handelt. Interessanterweise kann der Controller in dieser Architektur sehr simpel gehalten werden, etwa ein einfaches lineares Modell oder ein kleines neuronales Netz.

Die schwere kognitive Arbeit – das Verstehen, was man sieht (V), und das Vorhersagen, was passieren wird (M) – ist bereits erledigt. Der Controller erhält diese hochverarbeiteten Informationen und muss nur noch entscheiden, welche Aktion das Ziel am besten erreicht.

World Models: Abgrenzung zu ähnlichen Ansätzen

Es ist wichtig, World Models von verwandten Technologien abzugrenzen:

- Physik-Simulatoren (z. B. Unity, Unreal Engine) basieren auf fest programmierten Regeln, die von Menschen geschrieben wurden. World Models lernen diese Regeln aus Daten. Sie sind flexibler, aber weniger präzise.

- Bildgeneratoren (z. B. Midjourney) generieren statische Bilder ohne zeitliche Kohärenz oder Kausalität. Ein World Model ist inhärent dynamisch.

- Video-Generatoren (z. B. Sora) sind ebenfalls keine World Models. OpenAI nennt Sora einen World Simulator. Kritiker argumentieren jedoch, dass Sora nur Pixel-Korrelationen lernt, aber keine echte Objektpermanenz oder physikalische Interaktion simulieren kann . Ein echtes World Model ermöglicht Intervention und Planung, nicht nur passive Beobachtung.

World Models vs. Large Language Models (LLMs)

Die Dominanz von LLMs hat zu der Frage geführt: Verfügen LLMs nicht bereits über ein Modell der Welt? Diese Frage spaltet die KI-Gemeinschaft und erfordert eine differenzierte Betrachtung.

Kritiker wie Emily Bender und Yann LeCun argumentieren, dass LLMs fundamental anders funktionieren als World Models.

Ein LLM wie GPT-5.2 ist ein autoregressives Modell, das darauf trainiert ist, das nächste Token in einer Sequenz vorherzusagen. Es lernt die statistische Struktur von Sprache.

LeCun betont, dass Text eine sehr bandbreitenarme Repräsentation der Welt sei. Ein Kind lernt das Konzept der Schwerkraft in wenigen Monaten durch sensomotorische Interaktion, zum Beispiel, indem es Dinge fallen lässt. Ein LLM muss Miiliarden von Wörtern lesen, um das Wort "Schwerkraft" korrekt im Kontext zu verwenden. Doch es versteht die Physik nicht. Es kann halluzinieren, dass eine Schere ein Flugzeug durchschneiden kann, wenn die semantischen Assoziationen in den Trainingsdaten dies nahelegen, ohne die physikalische Unmöglichkeit zu erkennen.

Es gibt jedoch Forschung (z. B. Li et al., 2023 OthelloGPT), die zeigt, dass LLMs, wenn sie auf Zugfolgen von Brettspielen trainiert werden, intern eine Repräsentation des Spielbretts aufbauen – ein rudimentäres Weltmodell. Dies deutet darauf hin, dass LLMs in begrenzten Domänen Weltmodelle entwickeln können. Für die chaotische, kontinuierliche reale Welt scheint die reine Textbasis jedoch unzureichend.

Die folgende Tabelle verdeutlicht die fundamentalen Unterschiede in Architektur und Zielsetzung zwischen LLMs und World Models:

| Merkmal | Large Language Model (LLM) | World Model (Embodied AI) |

| Primäres Ziel | Generierung plausibler Texte / Token-Vorhersage | Vorhersage zukünftiger Umweltzustände & Belohnungen |

| Eingabedaten | Diskret (Text, Code), symbolisch | Kontinuierlich (Video, Lidar, Sensorik), hochdimensional |

| Lernparadigma | Self-Supervised Learning auf statischen Datensätzen | Model-Based Reinforcement Learning (oft interaktiv) |

| Interner Zustand | Attention-Mechanismus über Kontextfenster | Rekurrenter Zustand oder latente Dynamik |

| Verständnis | Semantisch, syntaktisch, narrativ | Kausal, räumlich-zeitlich, physikalisch |

| Planung | Begrenzt (Chain-of-Thought kann helfen) | Explizite Simulation (Rollouts) von Zukunfts-Szenarien |

| Typische Fehler | Halluzinationen (faktisch), Logikbrüche | Drift (akkumulierte Vorhersagefehler), Reality Gap |

Warum LLMs allein nicht reichen

LLMs extrahieren Bedeutung nur auf einer oberflächlichen Ebene. Wahre Intelligenz erfordert die Fähigkeit, in neuen Situationen zu planen. Ein LLM kann einen Plan für eine Reise schreiben, weil es Tausende Reiseberichte gelesen hat. Aber wenn man es bittet, einen Roboterarm zu steuern, um ein unbekanntes Werkzeug zu benutzen, scheitert es, weil ihm das implizite Wissen über Reibung, Gewicht und Balance fehlt.

World Models zielen darauf ab, dieses implizite, physikalische Common Sense-Wissen zu lernen, das in Texten selten explizit zu finden ist. Niemand schreibt in einem Roman: "Er hob das Glas, und aufgrund der Reibung zwischen Haut und Glas rutschte es nicht ab".

Intuition: Wie Maschinen träumen lernen

Um die Funktionsweise von World Models greifbar zu machen, stellen wir uns ein Gedankenexperiment vor, das auf einem Computerspiel basiert.

Zunächst agiert der Agent in der echten Welt (dem Spiel). Er sieht Bilder (Frames) und führt zufällige Aktionen aus.

Der VAE (das Auge) schaut sich Millionen dieser Bilder an. Er lernt, dass die wesentlichen Elemente des Spiels Wände, Gegner und Feuerbälle sind. Er lernt, diese Bilder in extrem kompakten Codes zu speichern.

Das RNN (das Gehirn) beobachtet den Strom dieser Codes. Es lernt Muster: Immer wenn der Code für ‚Feuerball' größer wird (näher kommt) und keine Bewegung stattfindet, folgt kurz darauf der Code für ‚Tod' (Spielende). Es lernt die Kausalität des Sterbens, ohne zu wissen, was Tod ist – nur, dass es ein Zustand ist, der vermieden werden sollte.

Nun geschieht das Revolutionäre. Wir trennen den Agenten von der Spiel-Engine. Wir geben dem RNN einen Startzustand und lassen es vorhersagen, was passiert. Das RNN generiert den nächsten Zustand. Wir füttern diesen vorhergesagten Zustand wieder als Input in das RNN ein. Das RNN beginnt, eine komplette Spielsequenz zu halluzinieren. Es träumt ein Spiel.

Der Controller (der Spieler) wird nun in diesem Traum aktiviert. Er spielt das Spiel, aber nicht auf dem Bildschirm, sondern im neuronalen Netz des World Models. Er feuert auf halluzinierte Gegner und weicht geträumten Feuerbällen aus.

Dieser Prozess kann tausendmal schneller ablaufen als das echte Spiel. Es ist keine Grafikberechnung nötig, nur reine Mathematik. Der Agent kann Millionen von Situationen trainieren.

Setzt man diesen Controller anschließend zurück in das echte Spiel, spielt er meisterhaft – obwohl er die echte Welt seit Beginn des Trainings nicht mehr gesehen hat. Er hat generalisierte Strategien aus seinem internen Weltmodell abgeleitet.

Ein Problem dieses Ansatzes ist, dass das Modell versucht, Bilder pixelgenau zu rekonstruieren. Das ist allerdings schwierig. Wenn man einen Baum im Wind filmt, bewegen sich tausende Blätter chaotisch. Ein Modell, das versucht, jedes Blatt vorherzusagen, verschwendet Rechenkapazität.

Yann LeCuns JEPA (Joint Embedding Predictive Architecture) löst dieses Problem. Es verzichtet auf den Decoder, der Bilder generiert. Stattdessen macht es Vorhersagen nur im abstrakten, latenten Raum.

Wenn Sie den Baum ansehen, sagen Sie nicht die Position jedes Blattes vorher. Sie sagen vorher: Der Baum steht noch da. JEPA lernt Repräsentationen, bei denen irrelevante Details ignoriert und nur relevante Zustände vorhergesagt werden. Das macht das Träumen effizienter und robuster gegenüber Rauschen.

Warum der Aufwand?

Die Implementierung von World Models ist technisch anspruchsvoll. Warum also nicht bei einfacheren Methoden bleiben? Die Vorteile sind in vier Schlüsselbereiche unterteilt.

Sample Efficiency (Lerneffizienz)

Dies ist der Heilige Gral der Robotik. Modellfreie Methoden, wie sie z. B. AlphaGo nutzt, benötigen Millionen von Spielen. In der Simulation ist das billig. In der Realität ist es unmöglich. Ein echter Roboter, der 10 Millionen Mal versucht, eine Tasse zu greifen und sie dabei fallen lässt, ist nach wenigen Tagen kaputt und verbraucht zu viele Ressourcen.

Mit World Models kann der Roboter die Physik der Tasse und seines Arms anhand weniger Daten lernen und dann das Greifen millionenfach in seinem Kopf per Simluation üben. Die Anzahl der nötigen Interaktionen mit der echten Welt sinkt drastisch.

Sicherheit und Safe Exploration

In sicherheitskritischen Umgebungen wie zum Beispiel in Chemie- und Atomkraftwerken oder im Straßenverkehr ist Trial-and-Error keine Option.

Ein World Model ermöglicht sogenanntes Counterfactual Reasoning: Was wäre passiert, wenn ich das Ventil geöffnet hätte? Der Agent kann katastrophale Handlungen simulieren, das negative Ergebnis vorhersagen und die Handlung unterlassen, ohne jemals Gefahr gelaufen zu sein. Dies ist notwendig für zertifizierbare KI-Sicherheit.

Planung und Reasoning (System 2 Thinking)

Der Nobelpreisträger Daniel Kahneman unterscheidet zwischen System 1 (schnelles, intuitives Denken) und System 2 (langsames, planendes Denken).

Reaktive KI ist System 1. World Models ermöglichen System 2. Der Agent kann innehalten, einen Entscheidungsbaum möglicher Zukünfte aufspannen (Rollouts), die verschiedenen Pfade bewerten und den optimalen wählen. Das ermöglicht langfristige Strategien, die über reines Reagieren hinausgehen.

Generalisierung auf neue Aufgaben

Ein World Model lernt die Umgebung, nicht die Aufgabe. Wenn ein Roboter gelernt hat, wie Objekte in einem Lagerhaus fallen und rutschen, kann dieses Wissen genutzt werden, um Kisten zu stapeln, aber auch um das Lager zu fegen. Ein modellfreier Agent, der nur fürs Stapeln trainiert wurde, müsste fürs Fegen komplett neu lernen. Das Weltmodell ist ein übertragbarer Wissensschatz.

Wenn die Simulation scheitert

Trotz des enormen Potenzials ist die Technologie von World Models noch nicht ausgereift.

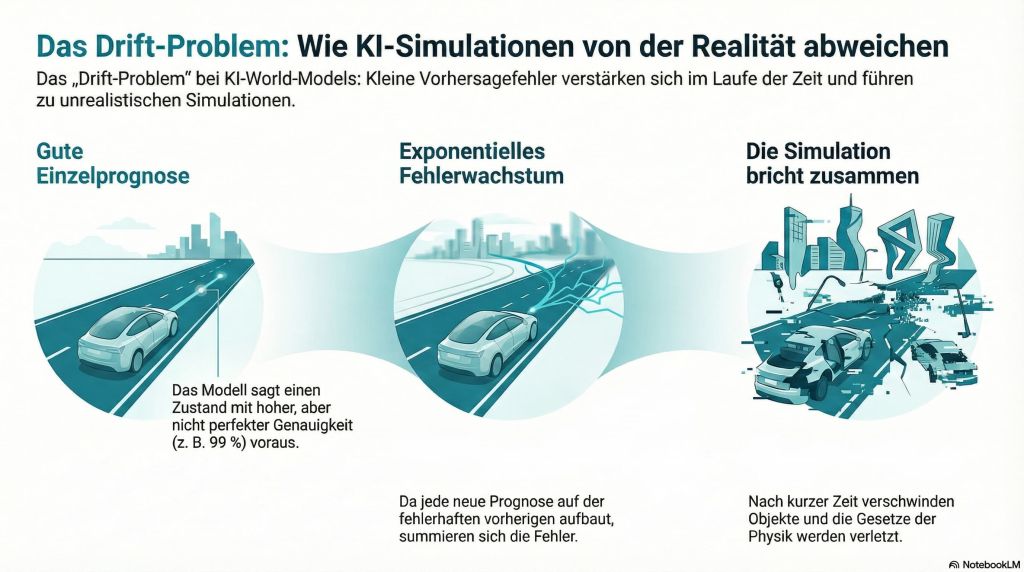

Das Drift-Problem: Halluzinationen der Physik

Das größte Problem von World Models ist die Fortschreibung von Fehlern. Wenn ein Modell einen Zustand mit 99 % Genauigkeit vorhersagt, ist das gut. Aber wenn es diesen vorhergesagten Zustand nutzt, um einen Folgezustand mit der gleichen Genauigkeit vorherzusagen, akkumulieren sich mit jedem weiteren Zustand die Fehler exponentiell.

Nach wenigen Sekunden Traumzeit divergiert die Simulation von der Realität. Objekte verschwinden, Wände lösen sich auf, Physikgesetze brechen zusammen. Das begrenzt den Planungshorizont oft auf kurze Zeitspannen. Forschungsarbeiten wie DreamerV3 oder Konsistenzmetriken wie der World Consistency Score – WCS versuchen, die Stabilität zu erhöhen, bleiben aber ein aktives Forschungsfeld.

Die Reality Gap

"Alle Modelle sind falsch, manche sind nützlich" – so sagte es einmal der britische Statistiker George E. P. Box Ein gelerntes World Model ist nie eine perfekte Kopie der Realität. Es ist eine Approximation.

Wenn ein Agent im Traum eine Lücke im Modell findet, die ihm unendliche Belohnung gibt, wird er diese Lücke als optimale Strategie lernen. In der echten Welt wird er dann zum Beispiel gegen die Wand fahren und scheitern. Dies nennt man Model Exploitation. Um das zu verhindern, muss das Modell seine eigene Unsicherheit kennen und dem Agenten mitteilen: Hier bin ich mir nicht sicher, probier das lieber nicht aus.

Rechenaufwand und Latenz

Das Trainieren großer World Models, insbesondere auf Grundlage von Videodaten, erfordert Rechenzentren voll mit GPUs. Für den Einsatz per Edge Computing, z. B. in einer Drohne oder einem Haushaltsroboter, sind diese Modelle oft noch zu schwergewichtig. Die Inferenz muss in Millisekunden geschehen, um in Echtzeit zu reagieren.

Evaluierung: FVD vs. Aufgabenerfolg

Wie misst man, ob ein World Model gut ist? Lange nutzte man Metriken wie FVD (Fréchet Video Distance), die messen, wie realistisch die generierten Videobilder aussehen. Doch das ist trügerisch. Ein Modell kann visuell perfekte Bilder generieren, die physikalisch unsinnig sind. Neuere Ansätze fordern Metriken, die den Erfolg bei der Aufgabe messen: Ein hässliches Modell, mit dem der Roboter die Kiste erfolgreich stapelt, ist besser als ein hübsches Modell, mit dem er scheitert.

Anwendungen: Wo World Models die Welt verändern

Robotik: die neue Autonomie

In der Robotik sind World Models der Schlüssel zur Manipulation komplexer Objekte. Das Fraunhofer-Institut für Produktionstechnik und Automatisierung (IPA) und Forscher weltweit arbeiten an Modellen für Roboter, die mit verformbaren Materialien wie Kabeln und Stoffen umgehen müssen. Weil es für Stoffe keine einfachen analytischen Formeln gibt, lernen die Roboter durch World Models die Dynamik des Faltens.

Ein weiteres Feld ist die Lokomotion. Roboter lernen in World Models das Laufen auf unebenem Terrain, indem sie Stürze millionenfach simulieren, bevor sie den ersten Schritt tun.

Autonomes Fahren: End-to-End Learning (Wayve, Waabi)

Traditionelle autonome Autos (AVs) bestehen aus modularen Blöcken, die von Ingenieuren programmiert wurden:

Wahrnehmung -> Lokalisierung -> Planung

Die neue Generation (AV 2.0) setzt auf End-to-End World Models. Unternehmen wie Wayve (mit dem Modell GAIA-1) oder Waabi entwickeln Modelle, die rohes Videomaterial aufnehmen und Fahrkommandos ausgeben.

Auf diese Weise kann GAIA-1 Szenarien träumen, die in der Realität selten sind; z. B. ein Kind springt hinter einem LKW hervor, während es schneit. Das Auto kann seine Reaktionen auf diese gefährlichen Situationen im Weltmodell trainieren. Waabis Copilot4D nutzt Lidar-Daten, 3D-Punktwolken, die durch Lasermessungen erstellt wurden, um vorherzusagen, wie sich die Umgebung, zum Beispiel andere Autos, auf die eigenen Aktionen hin verändern wird.

Life Sciences: virtual Cells als biologische Weltmodelle

Vielleicht die revolutionärste Anwendung von World Models liegt jenseits der sichtbaren Welt. Die Chan Zuckerberg Initiative (CZI) und Universitäten wie Yale entwickeln Virtual Cells – also virtuelle Körperzellen.

Eine Zelle ist ein komplexes dynamisches System. Ein World Model wird auf riesigen Mengen an Einzelzell-Sequenzierungsdaten (scRNA-seq) und Mikroskopiebildern trainiert.

Man kann in silico (im Computer) simulieren, was passiert, wenn man ein bestimmtes Gen ausschaltet – die sogenannte CRISPR-Perturbation – oder ein Medikament verabreicht. Das Modell sagt die Änderung des Zellzustands vorher.

Das Modell schlägt Experimente vor, die durchgeführt werden können, um seine Vorhersagen zu testen, und lernt aus den Ergebnissen. Das kann die Medikamentenentwicklung drastisch beschleunigen, weil Millionen Fehlschläge virtuell stattfinden.

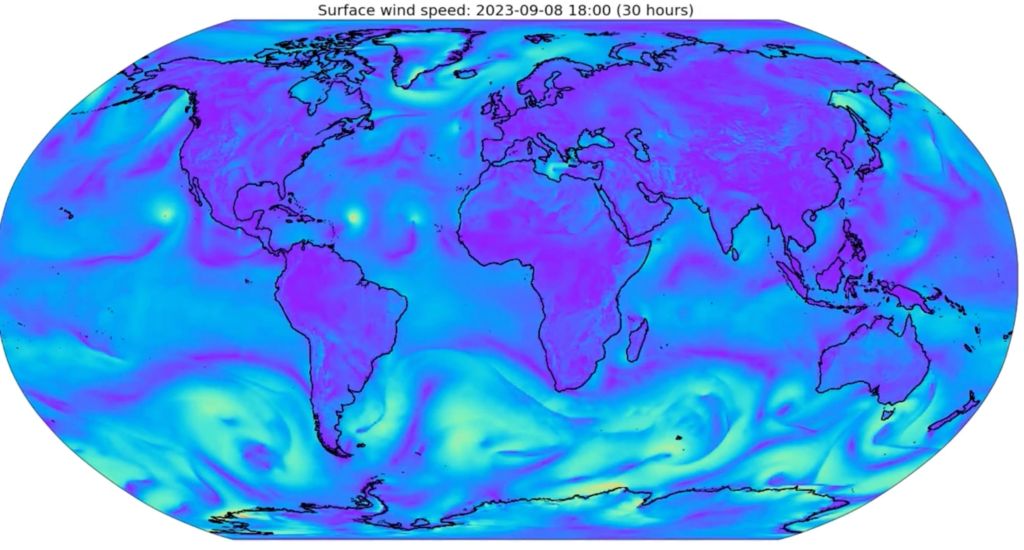

Wetter und Klima: GraphCast

Google DeepMinds GraphCast ist de facto ein World Model für das Erdklima. Anstatt die physikalischen Wettergleichungen numerisch zu lösen, wie bei klassischen Wettermodellen der Fall ist, hat GraphCast aus 40 Jahren historischer Wetterdaten gelernt, wie sich Druckgebiete und Fronten bewegen.

Es schlägt traditionelle Supercomputer-Modelle in Präzision und Geschwindigkeit bei der 10-Tages-Vorhersage. Es hat die Physik der Atmosphäre gelernt, ohne dass sie ihm explizit programmiert wurde.

Industrie 4.0: Offline Model-Based RL

In der Fertigung ist es oft zu teuer, Prozesse für das Training von KI zu stoppen. Offline MBRL (Offline Model-Based Reinforcement Learning) nutzt historische Datenlogs von Maschinen, um ein World Model des Fertigungsprozesses zu bauen.

In diesem Modell können dann Optimierungen wie z. B. Energieeinsparung oder Taktzeitverkürzungen getestet werden, ohne den laufenden Betrieb zu gefährden. Erst wenn die Strategie im Modell sicher funktioniert, wird sie auf die echte Maschine übertragen.

Ausblick: der Weg zur AGI?

Die Entwicklung von World Models ist ein Paradigmenwechsel, der uns näher an die Funktionsweise biologischer Intelligenz bringt.

Die Zukunft liegt wahrscheinlich in hybriden Architekturen. Ein LLM könnte als High-Level Planer fungieren, der einen abstrakten Wunsch wie zum Beispiel "Ich will Kaffee kochen" in das World Model einspeist. Das World Model simuliert dann die physikalischen Schritte wie Tasse greifen, Wasser einfüllen und prüft die Machbarkeit. LLMs liefern die Semantik, World Models die Physik.

Ähnlich wie GPT ein Foundation Model für Text ist, sehen wir das Entstehen von Foundation World Models für Robotik und Physik. Projekte wie Octo oder RT-2 versuchen, ein universelles Modell zu trainieren, das auf Daten von Tausenden verschiedenen Robotern gelernt hat und somit ein allgemeines Verständnis von Manipulation besitzt (General Purpose Robot Learning).

World Models ermöglichen Agentic AI: autonome Agenten, die langfristige Ziele verfolgen. Weil die Inferenz effizienter wird, werden diese Modelle zunehmend auf Edge-Geräten laufen, was eine Dezentralisierung der Intelligenz ermöglicht. Ein Roboter muss nicht mehr in der Cloud fragen, wie er die Tür öffnet; sein internes Weltmodell sagt es ihm.

Yann LeCun ist überzeugt: Solange KIs nicht lernen, die Welt so zu modellieren wie ein Kleinkind, werden sie dumme Fachidioten bleiben. World Models sind der Versuch, die KI erwachsen werden zu lassen.

FAQs: Häufig gestellte Fragen

Ist ein World Model dasselbe wie ein Digital Twin?

Ein Digital Twin ist oft ein hochpräzises, datengespeistes Abbild eines spezifischen physischen Objekts, oft basierend auf klassischen Simulationen. Ein World Model ist meist ein gelerntes neuronales Netz, das die allgemeinen Regeln einer Umgebung repräsentiert und besser generalisiert.

Warum programmieren wir die Physik nicht einfach ein?

Für einfache Systeme ist das möglich. Aber für die reale Welt sind die physikalischen Interaktionen zu komplex, chaotisch und vielfältig, um sie manuell in Formeln zu fassen. Ein World Model kann diese Regeln implizit aus visuellen Daten lernen, was robuster ist.

Können World Models Bewusstsein erlangen?

Das ist eine philosophische Debatte. Wenn man Bewusstsein funktional definiert als Fähigkeit eines Systems, sich selbst in einer Simulation der Zukunft zu repräsentieren, dann zeigen World Models rudimentäre Vorstufen davon. Von einem qualitativen Erleben sind sie jedoch technisch weit entfernt. Sie bleiben mathematische Optimierungsverfahren.

Was ist der Unterschied zu Sora oder Runway Gen-2?

Sora generiert Videos, die physikalisch aussehen, aber nicht unbedingt physikalisch konsistent sind. Ein Video-Generator muss nur das Auge täuschen. Ein World Model für einen Roboter muss physikalisch korrekte Vorhersagen machen. World Models enthalten oft Aktions-Variablen, was reine Video-Gens meist nicht tun.

Wo kann ich mehr über World Models lernen?

Empfehlenswert sind die Original-Paper "World Models" (Ha/Schmidhuber, 2018), "DreamerV3 "(Hafner et al.) sowie Yann LeCuns Positionspapier "A Path Towards Autonomous Machine Intelligence" (2022).

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Fujitsu startet neue Plattform für autonome und souveräne generative KI im Unternehmen

Fujitsu hat einen neue KI-Plattform entwickelt, die Unternehmen autonom verwenden können. Die Plattform soll die Entwicklung, den Betrieb und das

Cisco führt Intent-Based Policy Management für Netzwerke ein

Cisco hat ein absichtsbasiertes Policy Management für Netzwerke vorgestellt, das auf einer Mesh Policy Engine aufbaut. Das Intent-Based Policy Management

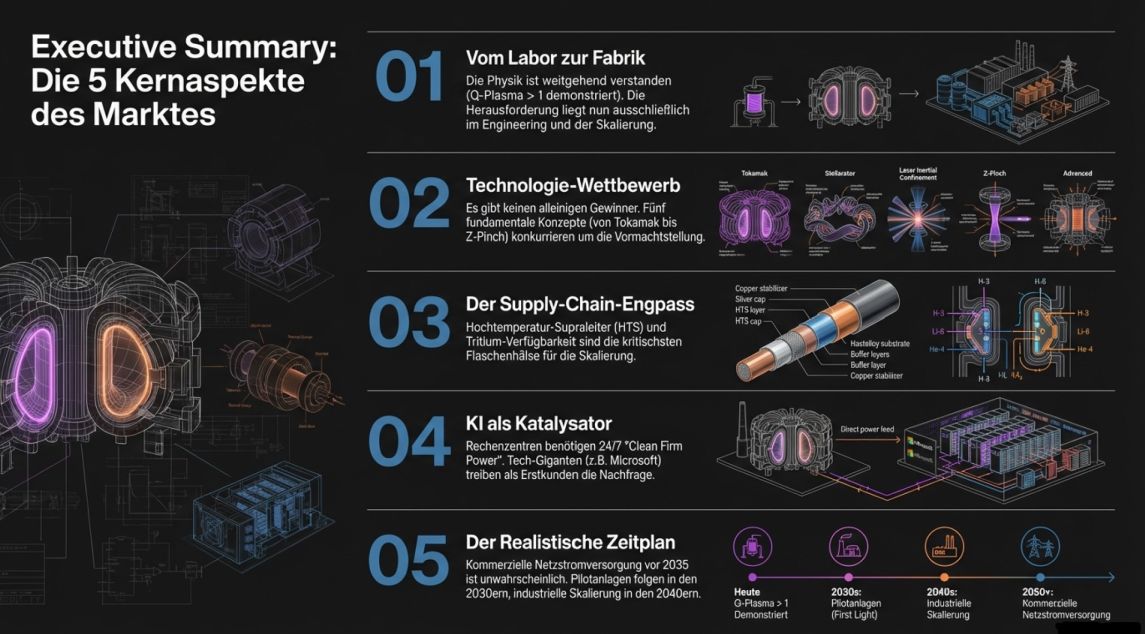

Kernfusion 2026: Vom Laborexperiment zur industriellen Realität

1. Executive Summary & Status Quo Der Paradigmenwechsel ist real – aber die Herausforderungen sind es auch Die Geschichte

Zum Inhalt springen

Zum Inhalt springen