Die Universität Tokio und Fujitsu wollen im Januar einen gemeinsamen Test für ein 'Workload Shifting' zwischen verschiedenen Rechenzentren beginnen. Das Pilotprojekt läuft bis zum 21. März 2026. Es ist Teil des „Watt-Bit Collaboration Project" in Zusammenarbeit mit dem Energieversorger TEPCO Power Grid.

Grundlagen des Workload Shiftings

Im Kern steht die Verschiebung der Arbeitslast, etwa bei komplexen Berechnungen oder Cloud-Diensten. Anstatt diese Aufgaben an einem einzigen, festen Ort zu verarbeiten, werden sie aktiv zwischen verschiedenen Rechenzentren verschoben.

Das Ziel ist eine Optimierung der Datenverarbeitung basierend auf externen Bedingungen. Faktoren für eine solche Verschiebung sind beispielsweise die aktuellen Strompreise, die Auslastung des Stromnetzes oder die Verfügbarkeit von erneuerbaren Energien an einem bestimmten Standort. Auch das Risiko von Ausfällen oder Verzögerungen wird bei der Aufteilung berücksichtigt.

Hintergrund: steigender Energiebedarf

Der Test ist eine Reaktion auf den schnell wachsenden Stromverbrauch durch Rechenzentren. Gleichzeitig speisen immer mehr verteilte Energiequellen wie Solaranlagen oder Windkrafträder Strom in die Netze ein. Das Projekt verfolgt den Ansatz, den Strombedarf und die Informationstechnologie nicht mehr getrennt, sondern als gekoppeltes System zu betrachten.

Die Partner wollen beweisen, dass man Rechenzentren dezentralisieren kann. Das kann dazu beitragen, die Infrastruktur zu entlasten, weil der Stromverbrauch der Computer dorthin verlagert wird, wo gerade Energie – vorzugsweise aus erneuerbaren Quellen – verfügbar ist.

Ablauf des aktuellen Tests

In der aktuellen Testphase überprüfen die Universität Tokio und Fujitsu, ob Berechnungen mithilfe von Container-Technologie standortunabhängig durchgeführt werden können. Container-Technologie verpackt Software so, dass sie auf unterschiedlichen Systemen ohne Anpassung läuft.

Die Universität Tokio stellt für den Versuch ihre Supercomputer-Systeme und Anwendungsfälle aus der KI-Forschung zur Verfügung. Fujitsu integriert die Technologie zur Lastverschiebung und stellt Cloud-Dienste bereit. Langfristig sollen so Technologien entstehen, die eine Datenverarbeitung in Regionen mit viel erneuerbarer Energie ermöglichen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Fujitsu startet neue Plattform für autonome und souveräne generative KI im Unternehmen

Fujitsu hat einen neue KI-Plattform entwickelt, die Unternehmen autonom verwenden können. Die Plattform soll die Entwicklung, den Betrieb und das

Cisco führt Intent-Based Policy Management für Netzwerke ein

Cisco hat ein absichtsbasiertes Policy Management für Netzwerke vorgestellt, das auf einer Mesh Policy Engine aufbaut. Das Intent-Based Policy Management

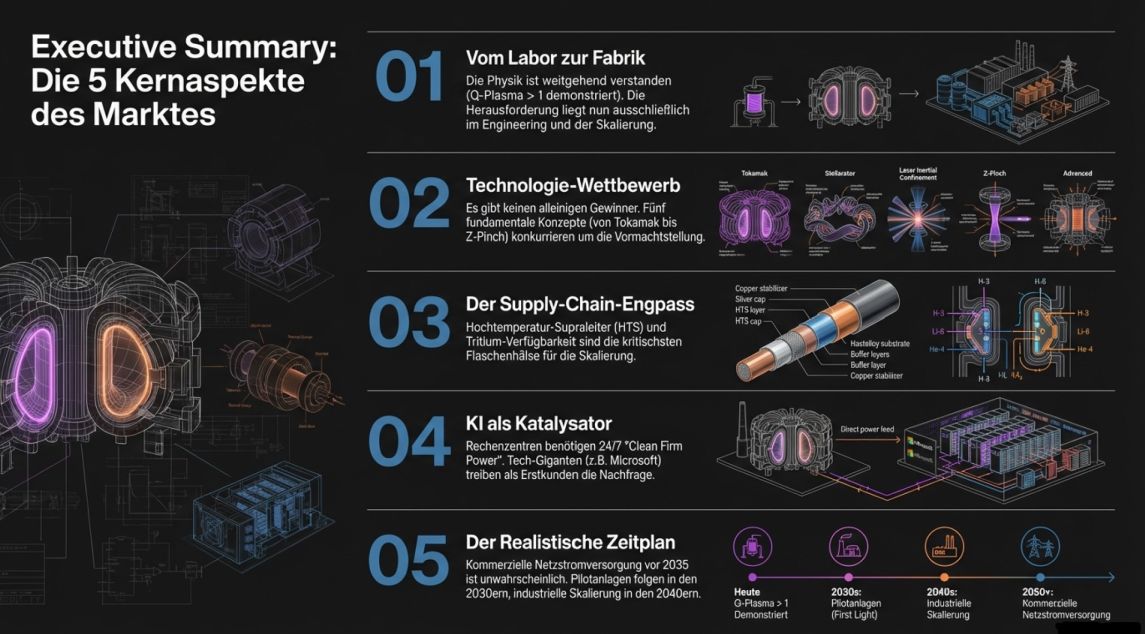

Kernfusion 2026: Vom Laborexperiment zur industriellen Realität

1. Executive Summary & Status Quo Der Paradigmenwechsel ist real – aber die Herausforderungen sind es auch Die Geschichte

Zum Inhalt springen

Zum Inhalt springen