Serverprobleme können den Geschäftsbetrieb empfindlich stören und erhebliche Kosten verursachen. Deshalb sind Vorbeugung, rechtzeitiges Erkennen von Problemen und zielgerichtete Reaktionen unverzichtbar. Wir zeigen, worauf es ankommt.

Das Wichtigste in Kürze

- Die meisten Unternehmen fordern heute eine Serververfügbarkeit von mindestens 99,99 Prozent, was weniger als einer Stunde Ausfallzeit pro Jahr entspricht.

- Sicherheitsvorfälle wie Ransomware und Exploits von Schwachstellen haben technisches Versagen als Hauptursache für Serverausfälle abgelöst.

- Die Kosten für eine Stunde Ausfallzeit liegen für die meisten großen Unternehmen bei über 100.000 Euro.

- Prävention erfordert eine Kombination aus technischer Redundanz (z. B. RAID, Cluster) und organisatorischer Wartung (Patches, Reinigung).

Definition: Wann spricht man von einem Serverfehler?

Es gibt zwei Betrachtungsweisen für Serverprobleme: die technische Fehlermeldung und die mangelnde Verfügbarkeit.

Betrachtet man Webserver, dann definiert die Internet Engineering Task Force (IETF) im Standard RFC 9110 Serverfehler durch Statuscodes im 500er-Bereich. Ein solcher Code signalisiert, dass der Server eine anscheinend gültige Anfrage nicht ausführen kann. Ein „500 Internal Server Error" weist auf unerwartete Bedingungen wie Skriptabstürze hin, während ein „503 Service Unavailable" meist eine temporäre Überlastung anzeigt.

Andere Serverarten wie zum Beispiel Datenbanken liefern bei Problemen je nach der verwendeten Software eigene Fehlercodes. Daher ist es wichtig, die jeweiligen Fehlercodes zu kennen und deren Auftreten zu überwachen.

Aus Sicht der Informationssicherheit fassen das National Institute of Standards and Technology (NIST) und das Bundesamt für Sicherheit in der Informationstechnik (BSI) den Begriff weiter. Ein Problem liegt bereits vor, wenn die Verfügbarkeit beeinträchtigt ist. Das umfasst den vollständigen Ausfall („Hard Down"), aber auch den Teilausfall („Brownout"), bei dem das System so langsam antwortet, dass Geschäftsprozesse nicht mehr funktionieren. Auch sporadische Fehler („Flapping"), bei denen ein System zwischen verfügbar und nicht verfügbar wechselt, zählen dazu.

Wie oft kommen Serverfehler in Unternehmen vor?

Die Häufigkeit von Fehlern wird oft anhand der erreichten Verfügbarkeit in „Neunen" (Nines) gemessen. Marktdaten von ITIC aus dem Jahr 2023 zeigen, dass die Ansprüche gestiegen sind: Während früher 99,9 Prozent Verfügbarkeit (ca. 8,76 Stunden Ausfall pro Jahr) akzeptiert wurden, strebten 2023 bereits 90 Prozent der Unternehmen eine Verfügbarkeit von 99,99 Prozent an. Das entspricht einer ungeplanten Downtime von 52 Minuten pro Server und Jahr.

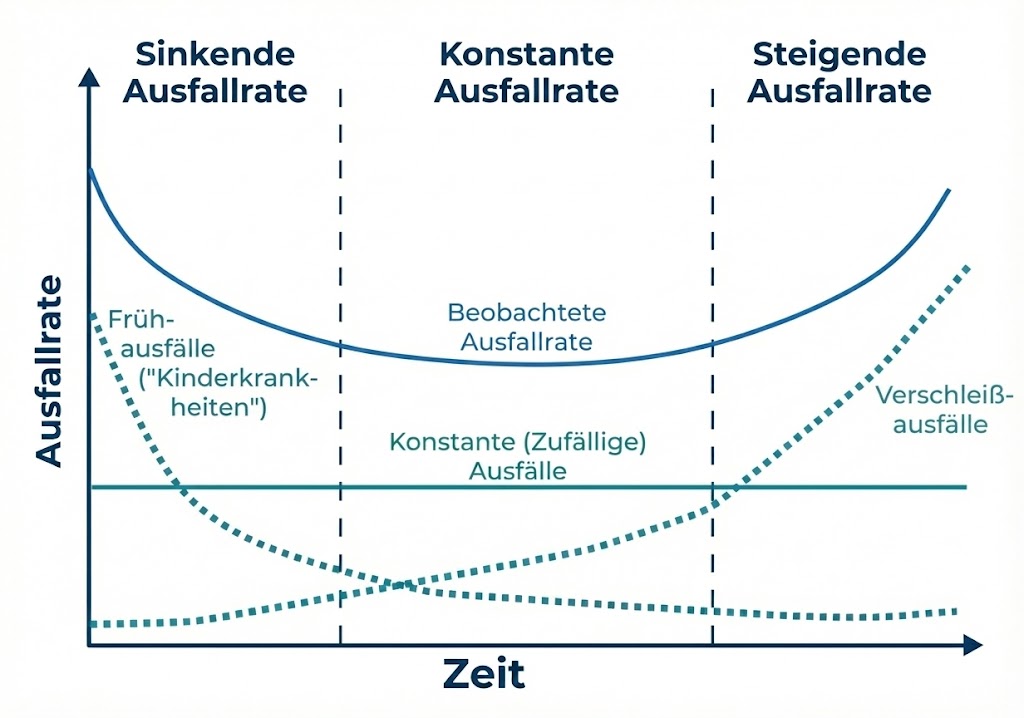

Steigt die Wahrscheinlichkeit eines Serverausfalls mit dem Alter? Das traditionelle Modell der Hardware-Zuverlässigkeit in Abhängigkeit ihres Alters ist die Badewannenkurve (Bath Tub Curve). Sie umfasst drei Phasen:

- Sinkende Ausfallrate: Ursachen sind Fertigungsfehler, Lötstellenprobleme oder Defekte im Silizium, also Kinderkrankheiten, die unter Stress früh versagen.

- Konstante Ausfallrate: zufällige Ausfälle durch externe Ereignisse (z.B. Spannungsspitzen, Vibrationen), die zeitunabhängig auftreten.

Steigende Ausfallrate: Verschleiß durch Materialermüdung, chemische Zersetzung oder mechanischer Abrieb dominiert.

Bild erstellt auf Grundlage von Wikipedia: Wyatts derivative work: McSush – Bathtub_curve.jpg – Creative Commons Lizenz

Server als komplexe Systemverbünde folgen allerdings selten einer einzigen Kurve. Vielmehr überlagern sich die unterschiedlichen Verteilungen der Subsysteme. Insbesondere bei elektronischen Komponenten (Halbleitern) wird die Existenz einer signifikanten Wear-Out-Phase innerhalb der typischen Nutzungsdauer (3–5 Jahre) zunehmend hinterfragt.

Dem ansteigenden Verschleiß kann durch regelmäßige Wartung vorgebeugt werden. Auch nach dem offiziellen EOL ist das mithilfe von Third Party Maintenance (TPM) kein Problem.

Die Wahrscheinlichkeit von Hardwarefehlern korreliert stark mit dem Alter der Geräte. Sobald Server älter als vier Jahre sind, steigen die Ausfallraten signifikant an, weil physische Komponenten wie Kondensatoren oder Lüfterlager verschleißen.

Häufige Kategorien von Serverproblemen und ihre Ursachen

Eine Analyse der Ausfallursachen zeigt, dass organisatorische und externe Faktoren oft kritischer sind als reine Hardwaredefekte.

Sicherheitsvorfälle

Laut einer ITIC-Umfrage sind Sicherheitsaspekte die häufigste Ursache für ungeplante Ausfallzeiten. Ransomware-Angriffe verschlüsseln Betriebssysteme und machen Server technisch unbrauchbar. DDoS-Angriffe überfluten Schnittstellen, sodass legitime Anfragen mit Fehlermeldungen abgewiesen werden.

Menschliches Versagen

Fehlentscheidungen oder Handhabungsfehler sind direkt oder indirekt für einen Großteil der Ausfälle verantwortlich. Häufige Ursachen sind Konfigurationsfehler, etwa in Firewalls oder Routing-Tabellen, sowie das Nichtbefolgen von definierten Prozessen. Ein prominentes Beispiel war ein fehlerhaftes Konfigurationsupdate von CrowdStrike im Jahr 2024, das weltweit Server lahmlegte.

Infrastruktur und Umwelt

Probleme mit der Stromversorgung verursachen einen großen Teil der schweren Ausfälle in Rechenzentren. Auch mangelnde Kühlung oder Staubablagerungen führen zu Überhitzung und automatischer Abschaltung der Systeme.

Hardware und Netzwerk

Physische Defekte betreffen oft mechanische Festplatten, Netzteile oder Arbeitsspeicher, bei denen „Bit Flips" zu Systemabstürzen führen können. Netzwerkprobleme stellen die größte Einzelursache für Service-Ausfälle dar, bei denen das System zwar läuft, aber nicht erreichbar ist.

Typische Auswirkungen und Risiken

Finanzielle Schäden

Die Kosten durch Ausfallzeiten sind enorm. Das Ponemon Institute hat gemeinsam mit IBM eine Studie zu den Kosten von Security Incidents durchgeführt. Die durchschnittlichen Kosten belaufen sich demnach auf rund 9.000 US-Dollar (rund 7.700 Euro) pro Minute. Diese Kosten entstehen durch Umsatzverluste und unproduktive Arbeitszeit der Mitarbeiter. Oft entstehen 20 bis 40 Prozent der Kosten bereits in der Phase, in der das Problem noch identifiziert wird.

Rechtliche Konsequenzen

Ein Serverausfall kann gegen gesetzliche Vorgaben verstoßen. Artikel 32 der Datenschutz-Grundverordnung (DSGVO) verpflichtet Unternehmen, personenbezogene Daten und die Systeme durch geeignete technische und organisatorische Maßnahmen (TOMs) zu schützen, auf denen sich die Daten befinden. Werden zum Beispiel durch fehlende Backups personenbezogene Daten vernichtet oder unzugänglich, drohen Bußgelder.

Serverausfälle vorbeugen

Prävention basiert auf Redundanz, Wartung und Systemhärtung.

Redundanz schaffen

Single Points of Failure (SPOFs) müssen eliminiert werden. Zu diesen Fehlerquellen gehören vor allem

- Datenspeicher: Der Einsatz von RAID-Systemen (Redundant Array of Independent Disks) schützt vor Festplattenausfällen. RAID 1 spiegelt Daten, während zum Beispiel RAID 7 Paritätsdaten nutzt, um Ausfälle zu kompensieren.

- Stromversorgung: Redundante Netzteile und unterbrechungsfreie Stromversorgungen (USV) sind notwendig, um Spannungsschwankungen abzufangen. USV-Batterien müssen regelmäßig getestet werden.

- Cluster: Mehrere einzelne Server, die sogenannten Knoten oder Nodes, arbeiten so zusammen, dass sie nach außen wie ein System wirken; oder sie erledigen zumindest gemeinsam eine Aufgabe. Eine spezielle Middleware bzw. Cluster-Software übernimmt die Steuerung. Die Ziele sind fast immer eine höhere Verfügbarkeit, mehr Leistung/Skalierung und einfachere Wartung.

Systematische Wartung

Eine systematische Serverwartung unterscheidet zwischen Hardware- und Softwarepflege, die jedoch untrennbar verbunden sind. Bei der Hardware steht die physische Reinigung im Vordergrund, weil Staub wie ein Wärmedämmstoff wirkt und zu Überhitzung führen kann. Zudem müssen mechanische Komponenten wie Lüfter auf Laufruhe geprüft und Verschleißteile wie Festplatten mittels S.M.A.R.T.-Werten überwacht werden, um Ausfälle vorherzusehen. Auch die Batterien der unterbrechungsfreien Stromversorgung (USV) benötigen monatliche Tests, um ihre Funktionsfähigkeit im Notfall zu garantieren.

Die Softwarewartung konzentriert sich primär auf das Patch-Management für Betriebssysteme und Firmware, um Sicherheitslücken zu schließen. Dabei gilt der Grundsatz, dass Updates niemals direkt auf dem Produktionssystem installiert werden sollten. Eine isolierte Testumgebung ist notwendig, um Fehler vorab zu identifizieren und den laufenden Betrieb nicht zu gefährden. Neben Updates umfasst die Softwarepflege auch das Entfernen alter Log-Dateien zur Speicherplatzfreigabe sowie die regelmäßige Prüfung von Benutzerrechten nach dem „Least Privilege"-Prinzip.

Ein oft vernachlässigter Aspekt ist die lückenlose Dokumentation jeder Änderung, um Fehlerursachen später nachvollziehen zu können.

Zur Wartung gehört zwingend der regelmäßige Restore-Test von Backups, weil eine Sicherung ohne geprüfte Wiederherstellung im Ernstfall wertlos sein kann. All diese Maßnahmen verlängern die Lebensdauer der Systeme und minimieren ungeplante Ausfallzeiten.

Hardening

Unter Hardening versteht man Maßnahmen, die dazu dienen, ein System gezielt so abzusichern, dass die Angriffsfläche möglichst klein wird. Man entfernt oder entschärft alles, was nicht nötig ist, und stellt sichere Standards ein.

Typische Hardening-Maßnahmen:

- Unnötige Dienste/Ports abschalten: z. B. alte Remote-Dienste, Demo-Services

- Software/OS aktuell halten: Patch- & Update-Management

- Sichere Konfigurationen setzen: z. B. starke TLS-Einstellungen, sichere Default-Policies

- Rechte minimieren: Least Privilege, getrennte Admin-Konten, Roll-Based Access Control (RBAC)

- Starke Authentifizierung: MFA, sichere Passwort-/Key-Policies

- Firewall/Netzwerksegmentierung: nur erlaubte Verbindungen, Zero-Trust-Ansätze

- Logging & Monitoring aktivieren: Audit-Logs, SIEM/Alerts

- Schutz vor Malware/Exploit: EDR/AV, Application Whitelisting, ASLR/DEP wo relevant

- Sichere Basis-Images/Benchmarks nutzen: z. B. CIS Benchmarks

- Backups & Recovery: regelmäßig, getestet, offline/immutable wenn möglich

Rechtzeitiges Erkennen von Serverproblemen

Ein durchdachtes und lückenloses Monitoring ist das Nervensystem der IT-Infrastruktur.

Monitoring-Methoden

Man unterscheidet zwischen agentenbasierter Überwachung, bei der Software auf dem Server installiert wird, und agentenloser Überwachung (via SNMP oder WMI), die Standardprotokolle nutzt. Agentenlose Methoden sind weniger invasiv, puffern Daten bei Netzwerkausfällen jedoch oft schlechter.

Wichtige Kennzahlen (KPIs)

Folgende Werte müssen überwacht werden, um Serverprobleme frühzeitig erkennen zu können:

- Erreichbarkeit: Ein einfacher Ping-Check oder Heartbeat.

- Ressourcen: Auslastung von CPU, RAM und Festplattenplatz. Volle Festplatten führen oft zum sofortigen Stillstand.

- Hardware-Gesundheit: S.M.A.R.T.-Werte der Festplatten und Status des RAID-Controllers.

- HTTP-Statuscodes: Ein Anstieg von 5xx-Fehlern deutet auf Probleme hin.

Bei Servern vor Ort helfen zudem die physische Inspektion der Status-LEDs und die Prüfung auf ungewöhnliche Lüftergeräusche.

Playbooks Incident Management: was im Einzelfall zu tun ist

Wenn ein Problem auftritt, strukturiert das Incident Management die Reaktion. Der Prozess folgt Standards wie ISO/IEC 27035 oder ITIL. Hier werden verschiedene sogenannte Playbooks angeboten – zum Beispiel für Incident Management und Change Management.

Rollenverteilung

Es sollte klar sein, wer Entscheidungen trifft (Incident Commander), wer die Technik repariert (Tech Lead) und wer kommuniziert (Communications Manager).

Exemplarischer Ablauf bei Nichterreichbarkeit

Ein Playbook definiert zu ergreifende Maßnahmen für spezifische Szenarien. Eine typische Reihenfolge bei Nichterreichbarkeit eines Servers ist zum Beispiel diese:

- Initialcheck: Sind Kabel und Stromversorgung intakt?

- IP-Check: Hat der Server eine gültige IP-Adresse?

- Netzwerkpfad: Nutzung von Tools wie ping und traceroute, um den Ort des Verbindungsabbruchs zu finden.

- Zugriff: Versuch des Logins über Notfall-Management-Konsolen (iLO, iDRAC), falls der normale Zugang scheitert.

- Neustart: Soft Reboot versuchen; nur im Notfall einen Hard Reset durchführen.

Business Continuity

Das Business Continuity Management (BCM) zielt darauf ab, den Geschäftsbetrieb während einer Störung aufrechtzuerhalten. Kern ist die Business Impact Analyse, die festlegt, wie lange ein Prozess maximal ausfallen darf.

Wichtige Kennzahlen sind:

- RTO (Recovery Time Objective): Die maximal erlaubte Zeit bis zur Wiederherstellung.

- RPO (Recovery Point Objective): Der Zeitraum, für den Datenverlust akzeptiert wird (z. B. 24 Stunden beim täglichen Backup).

Für die Wiederherstellung nutzen Unternehmen je nach Budget „Hot Sites" (gespiegelte Rechenzentren, sofort bereit), „Warm Sites" (Hardware vorhanden, Daten müssen eingespielt werden) oder „Cold Sites" (Räumlichkeiten vorhanden, Hardware muss beschafft werden).

FAQs: Antworten auf die 5 wichtigsten Fragen

Woran kann man Serverprobleme erkennen?

Serverprobleme äußern sich technisch oft durch HTTP-Fehlermeldungen im 500er-Bereich oder Timeouts. Spürbare Indikatoren sind extrem hohe Latenzzeiten und langsame Reaktionen bis hin zur völligen Nichterreichbarkeit. Warnsignale im Monitoring sind dauerhaft hohe Ressourcen-Auslastung oder volle Festplatten. Bei Hardware vor Ort weisen zudem gelbe Status-LEDs oder ungewöhnlich laute Lüftergeräusche auf Defekte hin.

Welches sind die häufigsten Serverprobleme?

Die Hauptursachen für Serverprobleme sind heute Sicherheitsvorfälle wie Ransomware und menschliches Versagen durch Konfigurationsfehler sowie Infrastrukturmängel bei der Stromversorgung und Kühlung. Während Hardwaredefekte seltener werden, stellen Netzwerkprobleme oft die größte Einzelursache für Service-Ausfälle dar.

Wie lassen sich Serverprobleme verhindern?

Prävention erfordert Redundanz durch RAID und Cluster sowie regelmäßige Wartung inklusive Patch-Management und Reinigung gegen Überhitzung. Updates müssen zwingend in Testumgebungen geprüft werden. Zudem minimiert Systemhärtung Angriffsflächen, während proaktives Monitoring Ressourcenengpässe frühzeitig erkennt.

Wie oft sollte ein Server neu gestartet werden?

Präventive Neustarts sind bei modernen Systemen selten nötig. Neustarts erfolgen meist nur nach Sicherheitsupdates für den Kernel oder Core-Services. Jeder Neustart birgt das Risiko, dass Dienste nicht korrekt starten.

Ersetzt ein RAID-System ein Backup?

Nein. Ein RAID schützt nur vor dem physischen Ausfall einer Festplatte und erhöht die Verfügbarkeit. Es hilft nicht gegen versehentliches Löschen, Malware, Feuer oder Diebstahl. Ein externes Backup nach der 3-2-1-Regel ist unverzichtbar.

Mein Server ist langsam, aber die CPU-Auslastung ist niedrig. Woran liegt das?

Das deutet oft auf einen I/O-Engpass hin („I/O Wait"). Der Prozessor wartet auf Daten von der Festplatte oder dem Netzwerk. Es sollten die Latenzzeiten der Datenträger oder der Status des RAID-Systems geprüft werden.

Wie gehe ich vor, wenn ein Server nach einem Update nicht mehr bootet?

Nutzen Sie den Zugang über Management-Konsolen (iLO/iDRAC). Versuchen Sie den abgesicherten Modus oder wählen Sie bei Linux einen älteren Kernel im Bootloader. Schlägt das fehl, ist eine Wiederherstellung aus dem Backup notwendig.

Bin ich von der NIS-2-Richtlinie betroffen?

Wenn Ihr Unternehmen in Sektoren wie Energie, Transport, Banken oder digitale Infrastruktur tätig ist und als mittleres Unternehmen mindestens 50 Mitarbeiter oder 10 Mio. Euro Umsatz haben, fallen Sie höchstwahrscheinlich unter die Richtlinie.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Weitere Artikel

NorthC baut neues Rechenzentrum ‘Frankfurt 2’ in Neu-Isenburg

In Neu-Isenburg im Süden von Frankfurt entsteht ein neues Rechenzentrum. Gebaut wird es vom europäischen Unternehmen NorthC. Der europäische Rechenzentrumsbetreiber

SaaS-pokalypse beginnt: Warum KI-Agenten ganze Branchen über Nacht obsolet machen

️ Über diese Episode In dieser explosiven Folge analysieren wir die größte Kapitalumschichtung der Tech-Geschichte: 630 Milliarden Dollar

Spotify setzt auf KI: keine Codezeile seit Dezember mehr durch beste Entwickler geschrieben

KI ersetzt bei Spotify mehr und mehr menschliche Softwareentwickler. Obwohl das Unternehmen in den letzten Monaten viele neue Features auf

Zum Inhalt springen

Zum Inhalt springen