Die Huxley-Gödel-Maschine (HGM) ist ein neues System, das die Weiterentwicklung von KI-Systemen deutlich beschleunigen könnte. Es wurde entwickelt, um sich selbst verbessernde Coding-Agenten zu erschaffen, die auf menschlichem Niveau programmieren können. Im Grunde stellt die HGM eine Annäherung an die optimale sich selbst verbessernde Maschine, dar, die sogenannte Gödel-Maschine (GM).

Die HGM wurde an der King Abdullah University of Science and Technology (KAUST) in Saudi-Arabien entwickelt. Zu den beteiligten Entwicklern gehört unter anderem der deutsche Informatiker Jürgen Schmidhuber.

Das Prinzip: Huxleys Clades und die Gödel-Maschine

Die HGM kombiniert zwei große Ideen:

Die erste Inspiration kommt vom theoretischen Konzept der Gödel-Maschine (GM). Die GM ist ein optimaler Problemlöser. Sie würde nur Selbstmodifikationen annehmen, die beweisbar den erwarteten langfristigen Nutzen steigern.

Die zweite entscheidende Idee stammt von Sir Julian Sorell Huxley, einem englischen Evolutionsbiologen. Geboren am 22. Juni 1887 in London, war er ein führender Vertreter der Modernen Synthese der Evolutionstheorie. Huxley war ein Gründungsmitglied des World Wildlife Fund (WWF). Er prägte den Begriff „Transhumanismus" im Jahr 1957. Kritisch wird seine Rolle im Hinblick auf die Eugenik gesehen.

Huxleys Beitrag zur HGM ist der Begriff der Klade (Clade). Eine Klade bezeichnet eine Abstammungslinie mit einem gemeinsamen Vorfahren.

Bisherige Methoden zur Selbstverbesserung stützten sich oft auf die aktuelle Leistung eines Agenten, die sofort messbar war. Doch die Forschung erkannte ein Problem: Ein Agent mit hohen Sofort-Ergebnissen bringt nicht unbedingt Nachkommen hervor, die sich langfristig weiter verbessern können. Dies wird als Metaproduktivitäts-Leistungs-Fehlverhältnis (Metaproductivity–Performance Mismatch, MPM) bezeichnet.

HGM löst dieses Problem, indem es die Clade-Metaproduktivität (CMP) nutzt. CMP misst das Potenzial eines Agenten zur langfristigen Selbstverbesserung. Das geschieht, indem die Benchmark-Ergebnisse der gesamten Nachkommenschaft (der Klade) eines Agenten zusammengefasst werden.

Der Zugriff auf die wahre CMP würde ausreichen, um die Gödel-Maschine in diesem Kontext zu simulieren. HGM ist somit eine Annäherung, die die CMP schätzt und als Leitfaden nutzt.

DGM und SICA: Die Vorgänger-Frameworks

Die Huxley-Gödel-Maschine (HGM) wurde entwickelt, um die Einschränkungen früherer, ebenfalls sich selbst verbessernder Frameworks zu überwinden, namentlich DGM und SICA.

Sowohl die Darwin Gödel Machine (DGM) als auch der Self-Improving Coding Agent (SICA) gehören zur Klasse der selbstreferenziellen KI. Diese Agenten verändern ihren eigenen Code und werden auf nachfolgenden Aufgaben empirisch validiert.

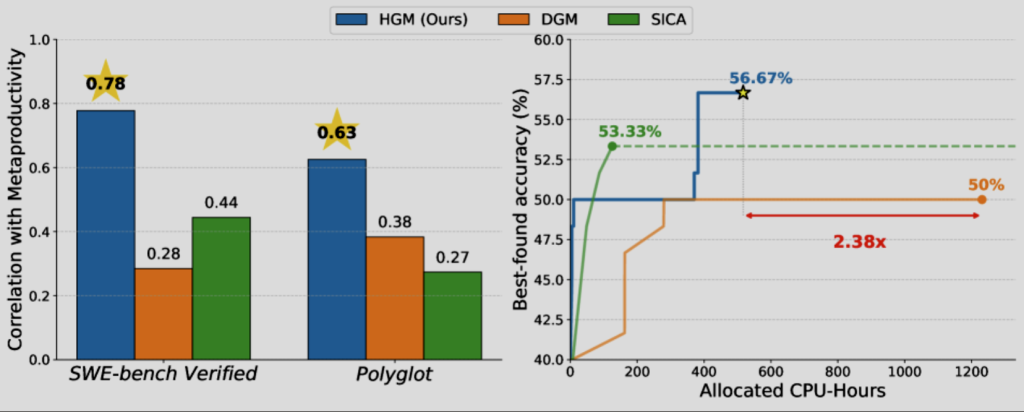

Die nachfolgende Grafik stammt aus der wissenschaftlichen Arbeit von Yimeng Chen, Mateusz Ostaszewski, Mingchen Zhuge, Jürgen Schmidhuber et al.

Abbildung 1 links: schwache Korrelation zwischen den Leitmetriken bei DGM und SICA – basierend auf Benchmark-Leistung – und langfristiger Selbstverbesserung. HGM erreicht durch kladenbasierte Metaproduktivität eine stärkere Korrelation. Rechts: Auf SWE-bench Verified erreicht HGM eine höhere Genauigkeit bei 2,38-mal weniger zugewiesenen CPU-Stunden.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Die Schwäche dieser früheren Ansätze liegt in ihrer Strategie der Selbstverbesserung:

- DGM und SICA gehen davon aus, dass bessere Benchmark-Ergebnisse auch vielversprechendere nachfolgende Selbstmodifikationen bedeuten. Sie verwechseln gewissermaßen die kurzfristige Leistung mit dem langfristigen Verbesserungspotenzial.

- Sie verfolgten eine starre Abfolge: Sie erzeugten einen Nachkommen (Expansion) und bewerteten diesen dann sofort an mehreren Aufgaben.

- Die Evaluierungsrichtlinie von SICA besteht darin, den zuletzt erstellten Agenten auf dem gesamten Evaluierungsdatensatz zu testen.

- Die Evaluierungsrichtlinie von DGM besteht darin, den zuletzt erstellten Agenten schrittweise auf Teilmengen des Datensatzes zu testen und die Expansion fortzusetzen, wenn die Ergebnisse vielversprechend waren.

Diese Strategie ist unflexibel. Ein neuer Agent, der auf verschiedenen Aufgaben fehlschlug, verbrauchte weiterhin Ressourcen für Tests, während vielversprechendere, ältere Agenten ignoriert wurden. HGM hingegen hat eine adaptive Steuerung und entkoppelt Expansion und Evaluierung.

Die Funktionsweise und der Algorithmus

Die Selbstverbesserung wird als eine iterative Baumsuche betrachtet. Das Ziel ist, den Agenten mit der besten Leistung zu finden.

Der HGM-Algorithmus schätzt die CMP und nutzt diese Schätzung, um die Suche zu leiten. Er bricht die starre Reihenfolge von DGM und SICA auf. Die Ausführung kann sogar asynchron erfolgen, was die Effizienz steigert.

Der HGM-Algorithmus hat drei adaptive Richtlinien, um die Baumsuche zu steuern:

- Die Auswahlrichtlinie (Selection Policy): Die HGM entscheidet adaptiv, ob sie expandieren (neue Agenten generieren) oder evaluieren (bestehende Agenten testen) soll.

- Die Expansionsrichtlinie (Expansion Policy): Diese wählt den Eltern-Agenten aus, der modifiziert werden soll. Die HGM wählt den Agenten, dessen Klade das höchste geschätzte CMP-Potenzial aufweist. Die CMP-Schätzung basiert auf der gewichteten Aggregation der empirischen Leistungen aller Agenten in der Klade, was zu statistisch robusteren Schätzungen führt.

- Die Evaluierungsrichtlinie (Evaluation Policy): Diese wählt einen bestehenden Agenten für weitere Tests aus. Die Evaluierung findet immer nur für ein einzelnes Agent-Aufgaben-Paar statt. Dadurch können solche Agenten früher gestoppt werden, von denen keine guten Ergebnisse erwartet werden.

Die Möglichkeiten

Die CMP-basierte Steuerung führte in Tests zu qualitativ besseren Agenten. HGM ist zudem deutlich effizienter in Bezug auf die benötigte CPU-Zeit im Vergleich zu DGM und SICA. Auf dem SWE-bench Verified-60 Benchmark benötigte HGM 2,38-mal weniger CPU-Stunden als DGM.

Ein entscheidender Erfolg ist die Übertragbarkeit der Verbesserungen.

- Der durch HGM optimierte Agent, der mit dem GPT-5-mini-Modell trainiert wurde, erreichte die Spitze der GPT-5-mini-basierten Systeme auf dem SWE-Verified-Leaderboard.

- Als dieser Agent später mit dem größeren GPT-5-Modell getestet wurde (auf einem anderen Datensatz, SWE-bench Lite), war seine Leistung vergleichbar mit den besten offiziell verifizierten, von Menschen entwickelten Coding-Agenten. Das zeigt, dass HGM echte Design-Verbesserungen erzeugt und nicht nur eine Überanpassung (Overfitting) an das Trainings-Setup.

Mögliche Entwicklungen in der Zukunft

Die Forschungsergebnisse legen nahe, dass das langfristige Potenzial zur Selbstverbesserung wichtiger ist als die sofortige Leistung.

Die CMP-basierte Steuerung deutet auf ein neues Paradigma hin: Die zukünftige Entwicklung von Agenten wird durch die generative Kraft ihrer gesamten Abstammungslinie geleitet.

Es wurden bereits spannende Verhaltensweisen der Agenten beobachtet: Agenten implementierten eine selbstmotivierte iterative Verfeinerung. Das bedeutet, sie führten mehrere Selbstmodifikationen in einem einzigen Expansionsschritt durch. Das verdeutlicht das Potenzial für willkürlich tiefgreifende Meta-Verbesserungen.

Weitere Artikel

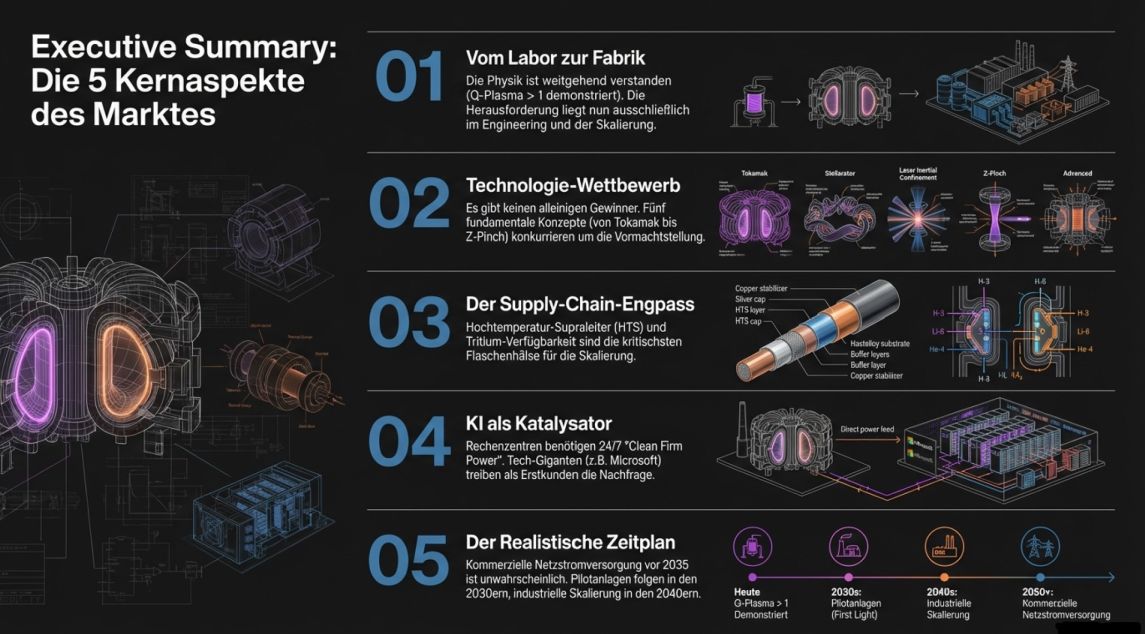

Kernfusion 2026: Vom Laborexperiment zur industriellen Realität

1. Executive Summary & Status Quo Der Paradigmenwechsel ist real – aber die Herausforderungen sind es auch Die Geschichte

Gute Zahlen bei ASML bestätigen anhaltenden KI-Boom

ASML, der niederländische Hersteller von Lithografiemaschinen, hat starke Zahlen vorgelegt, die zeigen, dass der Boom bei KI und dem

Von Cerebras bis Stargate: Wie KI-Infrastruktur die Tech-Welt revolutioniert – und welche Probleme jetzt akut werden

️ Über diese Episode In dieser vollgepackten Folge diskutieren Christian und Yusuf die wichtigsten KI- und Tech-Entwicklungen der

Zum Inhalt springen

Zum Inhalt springen