Die Thousand Brains Theory beschreibt einen neuen Ansatz, der auf Grundlage der Struktur des menschlichen Gehirns künstlicher Intelligenz zu bisher ungeahnten Fähigkeiten führen könnte.

TL;DR: die 5 wichtigsten Informationen zur Thousand Brains Theory

- Begrenzungen heutiger KI: Aktuelle KI-Systeme wie Deep Learning sind leistungsfähig, aber fragil, datenhungrig und ohne echtes Weltverständnis oder „Common Sense".

- Grundidee der Thousand Brains Theory: Jeff Hawkins' Theorie besagt, dass der Neokortex aus Tausenden kortikaler Säulen besteht, die jeweils vollständige Modelle der Welt bilden.

- Zentrale Mechanismen: Intelligenz entsteht laut TBT durch sensomotorisches Lernen, Referenzrahmen und die Zusammenarbeit vieler Module über ein „Voting"-Prinzip.

- Unterschied zu Deep Learning: Während heutige KI statistische Muster erkennt, baut TBT strukturierte, objektzentrierte Weltmodelle, die Robustheit, Effizienz und echtes Verständnis ermöglichen.

- Potenzial für AGI: Die TBT könnte als Bauplan für eine kontrollierbare, allgemein intelligente KI dienen, die Wissen strukturiert aufbaut, aber keine unkontrollierbaren Ziele verfolgt.

Teil 1: Das Rätsel der Intelligenz – Ein neuer Blick ins Gehirn

Die brillante, aber auch zerbrechliche KI

KI erlebt derzeit einen unbestreitbaren Siegeszug. Systeme, die auf Deep Learning basieren, schreiben Gedichte, komponieren Musik, erkennen komplexe Muster in medizinischen Scans und besiegen uns in den kompliziertesten Strategiespielen. Wir interagieren täglich mit einer Form von KI, die vor nur einem Jahrzehnt noch wie Science-Fiction gewirkt hätte.

Doch trotz dieser beeindruckenden Fähigkeiten fehlt den heutigen KIs etwas Grundlegendes. Wer sie intensiv nutzt, erkennt schnell ihre Grenzen. Ihre Intelligenz ist zerbrechlich und engstirnig. KI lernt nicht kontinuierlich dazu, sondern muss in gigantischen Rechenläufen trainiert werden. Stellt man ihr eine Frage, die nur leicht von ihren Trainingsdaten abweicht, versagt sie oft auf absurde Weise. Vor allem aber fehlt ihr jedes echte Verständnis der Welt. Sie weiß nicht, warum eine Zitrone sauer ist oder warum ein Ball, den man loslässt, zu Boden fällt. Ihr fehlt der „gesunde Menschenverstand" der "Common Sense".

Diese Diskrepanz wirft eine fundamentale Frage auf: Wenn unsere Maschinen so anders lernen als wir, verstehen wir vielleicht das menschliche Lernen – die ultimative Blaupause für Intelligenz – von Grund auf falsch?

Hier setzt der Forscher und Unternehmer Jeff Hawkins mit seiner Thousand Brains Theory (TBT) an. Er argumentiert, dass wir, um intelligentere Maschinen zu bauen, zunächst den Code des Gehirns knacken müssen. Seine Theorie ist ein Entwurf, der nicht nur unser Verständnis des Gehirns auf den Kopf stellt, sondern auch einen völlig neuen Weg für die Zukunft der KI aufzeigt.

Der Architekt unserer Gedanken: der Neokortex

Um die TBT zu verstehen, müssen wir uns den Hauptakteur im Gehirn ansehen: den Neokortex. Das ist die große, stark gefaltete äußere Schicht unseres Gehirns, die oft wie ein Walnusskern aussieht. Beim Menschen macht der Neokortex etwa 70% des gesamten Gehirnvolumens aus.

Der Neokortex ist der Sitz unserer höchsten kognitiven Fähigkeiten. Alles, was wir mit menschlicher Intelligenz verbinden, entsteht hier: unsere Fähigkeit zu sehen und zu hören, unsere Sprache, das Verständnis für Musik, das Lösen von mathematischen Problemen und das abstrakte Denken, das uns befähigt, über Wissenschaft oder Philosophie zu debattieren. Während ältere Gehirnteile (das „alte Gehirn") grundlegende Überlebensfunktionen, Instinkte und Emotionen steuern, ist der Neokortex das Organ der Intelligenz.

Das Faszinierendste am Neokortex ist jedoch nicht, was er tut, sondern, wie er aufgebaut ist. Mitte des 20. Jahrhunderts machte der Neurowissenschaftler Vernon Mountcastle eine bahnbrechende Entdeckung, die die Grundlage für Hawkins' Arbeit legt: Der Neokortex sieht, unter dem Mikroskop betrachtet, überall bemerkenswert gleich aus. Die Struktur der Neuronen im visuellen Kortex (zuständig für das Sehen) ist im Wesentlichen dieselbe wie im auditorischen Kortex (zuständig für das Hören) oder im somatosensorischen Kortex (zuständig für das Fühlen).

Die Suche nach dem Universal-Algorithmus

Diese strukturelle Einheitlichkeit des Neokortex liefert uns wichtige Hinweise auf die Funktionsweise von Intelligenz.

Wenn verschiedene kognitive Aufgaben wie das Erkennen eines Gesichts, das Verstehen eines Satzes oder das Greifen nach einer Tasse alle im Neokortex stattfinden und dieser Neokortex überall gleich aufgebaut ist, dann kann Intelligenz kein „Schweizer Taschenmesser" aus vielen verschiedenen, spezialisierten Werkzeugen sein. Stattdessen muss der Neokortex einen einzigen, universellen Algorithmus verwenden.

Dieser Algorithmus muss so fundamental und flexibel sein, dass er jede Art von Information verarbeiten kann, die ihm zugeführt wird – ob es sich um visuelle Daten von den Augen, auditive Daten von den Ohren oder Tastinformationen von den Händen handelt.

Diese Erkenntnis hat große Auswirkungen auf die Erforschung der Künstlichen Allgemeinen Intelligenz (AGI). Sie legt nahe, dass wir nicht Tausende verschiedener kognitiver Funktionen (Sehen, Sprechen, Planen etc.) mühsam einzeln nachbilden müssen. Wenn es uns gelingt, diesen einen universellen Algorithmus des Neokortex zu entschlüsseln und in Form von Hard- und Software nachzubilden,, könnten wir den Schlüssel zur wahren Maschinenintelligenz in den Händen halten.

Die „Thousand Brains Theory" von Jeff Hawkins ist der bisher ehrgeizigste Versuch, genau diesen universellen Algorithmus zu beschreiben.

Teil 2: Die „Thousand Brains Theory" entschlüsselt

Die Kernidee: Tausende Modelle, nicht ein einziges

Die traditionelle Neurowissenschaft ging lange davon aus, dass das Gehirn hierarchisch funktioniert. Man stellte es sich so vor, dass Sinneseindrücke (wie Pixel von der Netzhaut) an der untersten Stufe eingespeist und dann Schritt für Schritt nach oben weitergeleitet werden: von Pixeln zu Kanten, zu Formen, zu Objekten, bis ganz oben an der Spitze der Hierarchie ein einziges, umfassendes Modell der Welt entsteht.

Die Thousand Brains Theory bricht radikal mit dieser Vorstellung. Jeff Hawkins und sein Team bei Numenta schlagen vor, dass das Gehirn nicht ein riesiges Modell der Welt erstellt, sondern Zehntausende.

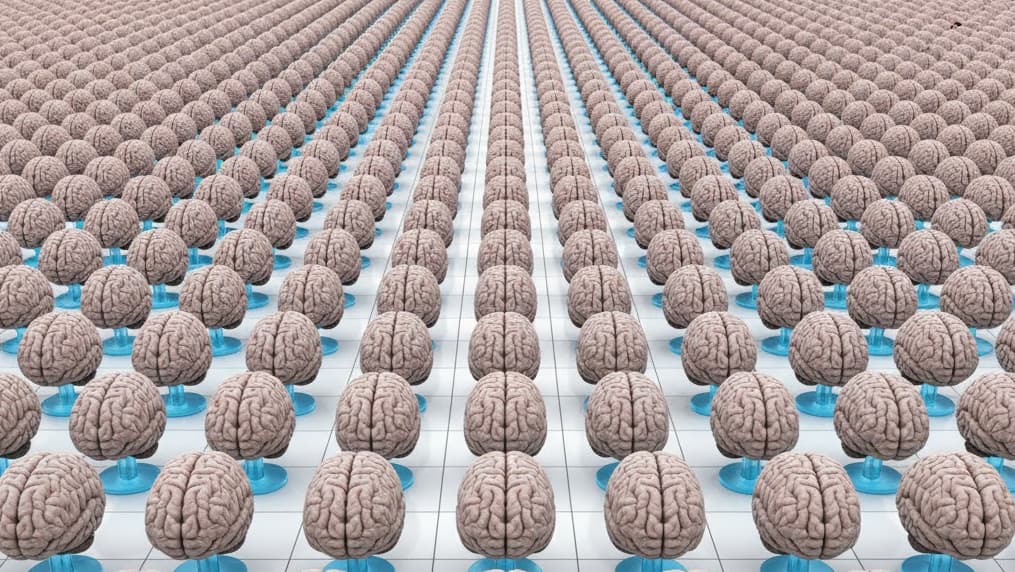

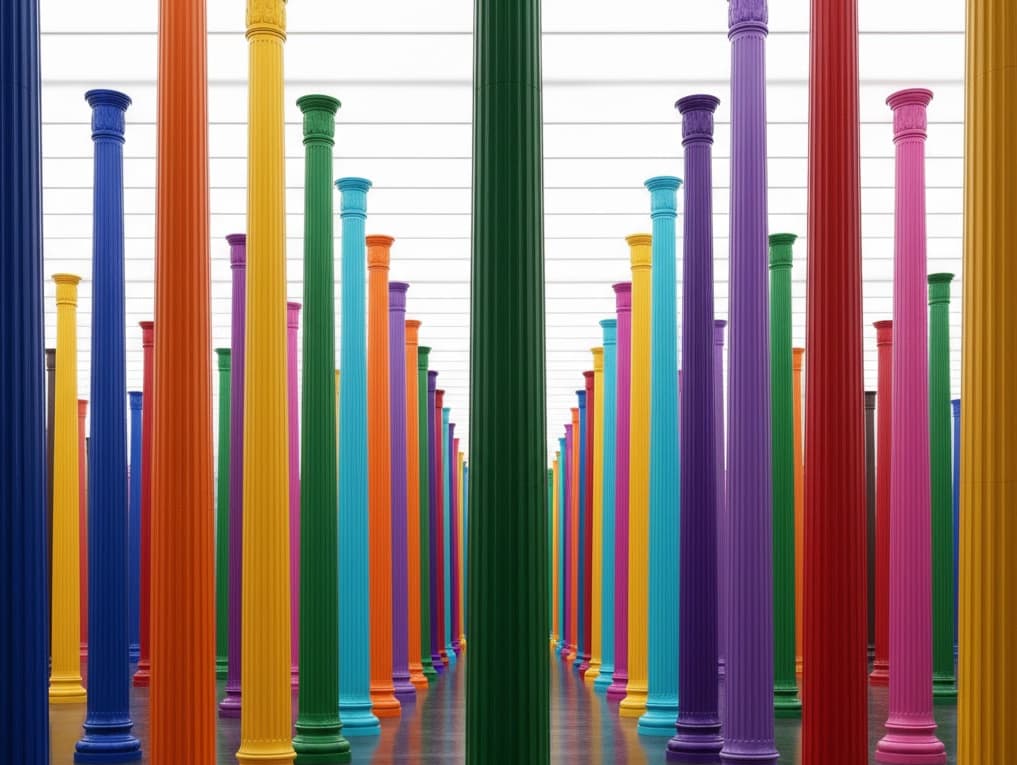

Der Neokortex ist in etwa 150.000 winzige, vertikale Einheiten unterteilt, die als kortikale Säulen (Cortical Columns) bezeichnet werden. Die TBT postuliert, dass jede einzelne dieser Säulen wie ein komplettes, eigenständiges Gehirn im Miniaturformat funktioniert. Jede Säule, egal, wo sie sich im Neokortex befindet, lernt ein vollständiges Modell der Objekte und Konzepte in ihrer Welt.

Das Gehirn erstellt also nicht ein Modell einer Kaffeetasse, sondern Tausende von Modellen parallel – ein Modell in den Säulen, die mit dem Zeigefinger verbunden sind, ein anderes in den Säulen für den Daumen, und Tausende weitere in den Säulen für das Sehen.

Der Schlüssel zum Verständnis: Referenzrahmen

Diese Behauptung wirft eine offensichtliche Frage auf: Wie kann eine winzige kortikale Säule, die vielleicht nur die Tastempfindungen eines einzigen Fingers verarbeitet, ein komplettes 3D-Modell einer Kaffeetasse lernen?

Die Antwort ist der vielleicht wichtigste und eleganteste Baustein der TBT: Referenzrahmen (Reference Frames).

Ein Referenzrahmen ist am besten als ein unsichtbares, mentales Koordinatensystem oder ein „GPS" zu verstehen, welches das Gehirn für jedes Objekt erstellt, das es lernt. Das Gehirn lernt nicht nur, was es fühlt (z.B. „glatte Oberfläche"); entscheidend ist, wo es das Merkmal im Verhältnis zum Objekt fühlt (z.B. „3 cm links vom Henkel").

Wissen wird im Gehirn gespeichert, indem Sinneswahrnehmungen an bestimmte Orte innerhalb eines Referenzrahmens gekoppelt werden. Das Modell einer Kaffeetasse ist also nicht einfach ein „Objekt", sondern eine Sammlung von Merkmalen (glatt, hart, gebogen, Henkel) an bestimmten, relativen Orten in einem 3D-Modell.

Das „GPS" des Gehirns: Die Rolle der Gitterzellen

Woher nimmt der Neokortex diese Referenzrahmen? Hawkins' Hypothese dazu ist revolutionär, weil sie eine Brücke zu einem anderen, bereits bekannten System im Gehirn schlägt.

Im „alten Gehirn" (speziell im entorhinalen Kortex) gibt es Neuronen, die Gitterzellen (Grid Cells) genannt werden. Diese Zellen wurden 2005 entdeckt (eine Entdeckung, die 2014 mit dem Nobelpreis gewürdigt wurde). Gitterzellen fungieren als Navigationssystem des Gehirns. Sie feuern in einem stabilen, gitterartigen Muster, während wir uns durch einen Raum bewegen, und teilen dem Gehirn mit, wo wir uns befinden.

Hawkins vermutet nun, dass Kopien dieses Navigationssystems überall im Neokortex existieren, in jeder einzelnen kortikalen Säule. Diese kortikalen Gitterzellen verfolgen jedoch nicht unsere Position im Raum. Stattdessen verfolgen sie die Position unserer Sensoren (Augen, Finger, Haut) relativ zu dem Objekt, das wir gerade wahrnehmen.

Wenn Ihr Finger über eine Tasse streicht, generieren die Gitterzellen in der zuständigen kortikalen Säule den Referenzrahmen (das "GPS der Tasse") und verfolgen die Position Ihres Fingers innerhalb dieses Rahmens.

Lernen durch Handeln: sensomotorische Integration

Dieser Mechanismus verbindet nun alle Teile miteinander. Das Gehirn lernt nicht passiv wie eine Kamera, die Bilder aufnimmt. Es lernt durch Bewegung. Intelligenz ist ein aktiver Prozess, den die TBT als sensomotorisches Lernen oder sensomotorische Integration bezeichnet.

Stellen wir uns das Beispiel mit der Kaffeetasse noch einmal detailliert vor. Wenn Ihr Finger über die Tasse fährt, passieren in der kortikalen Säule drei Dinge gleichzeitig:

- Sensorik: Sensorische Neuronen feuern und melden: „Ich fühle eine glatte, harte, kühle Oberfläche."

- Motorik: Das Gehirn sendet gleichzeitig Bewegungssignale an den Finger.

- Referenzrahmen: Die Gitterzellen in derselben Säule aktualisieren die Position des Fingers relativ zur Tasse (z.B. „jetzt am oberen Rand", „jetzt am Henkel").

Die kortikale Säule lernt nun, diese Dinge miteinander zu verknüpfen. Sie lernt: „Am Ort A (oberer Rand) erwarte ich, ‚glatt und rund' zu fühlen." und „Am Ort B (Henkel) erwarte ich, ‚gebogen' zu fühlen.". Das Modell der Tasse ist die Summe dieser Verknüpfungen von Empfindungen mit Orten. Durch die Bewegung des Fingers kann eine einzige Säule das gesamte Objekt abscannen und ein vollständiges 3D-Modell davon erstellen.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Das große Ganze: Konsens durch Abstimmung (Voting)

Wenn wir nicht nur einzelne, sondern Zehntausende dieser Modelle parallel in unserem Kopf haben – Tausende von der visuellen Wahrnehmung, Tausende von jeder Fingerberührung –, warum erleben wir die Welt dann als einheitliches, stabiles Ganzes? Wie können wir eine Tasse sofort erkennen, wenn wir sie nur ansehen oder kurz greifen?

Die Antwort der TBT lautet: Konsens durch Abstimmung (Voting).

Die Tausenden kortikalen Säulen sind untereinander über weitreichende Verbindungen vernetzt. Wenn wir eine Tasse greifen, beginnen alle beteiligten Säulen, ihre Modelle zu aktivieren. Die Säule des Zeigefingers sagt: „Was ich fühle, passt zu 80% zu meinem Tassen-Modell." Die Säule des Daumens meldet: „Passt zu 85% zu meinem Tassen-Modell." Und die Säulen des visuellen Systems melden: „Was wir sehen, passt zu 90% zu einem Tassen-Modell."

Über die weitreichenden Verbindungen stimmen die Säulen miteinander ab. Sie teilen ihre Hypothesen und einigen sich innerhalb von Millisekunden auf einen stabilen Konsens: „Es ist eine Tasse."

Dieser Mechanismus erklärt, warum unsere Wahrnehmung so unglaublich robust ist. Selbst wenn ein Teil der Information fehlt oder mehrdeutig ist (z.B. im Dunkeln), können die anderen Säulen die Lücke füllen und zu einer stabilen Wahrnehmung beitragen.

Implikation: Intelligenz ist nicht Hierarchie, sondern Verteilung

Diese Funktionsweise stellt die traditionelle hierarchische Sichtweise des Gehirns und der KI auf den Kopf.

Das klassische Modell besagt: Informationen fließen von unten nach oben. Ein Objekt gilt erst an der Spitze der Hierarchie als „erkannt".

Die TBT zeigt, dass dies nicht stimmen kann. Die Tatsache, dass ein einzelner Finger, der sich über ein Objekt bewegt, dieses Objekt erkennen kann, beweist, dass eine niedrige kortikale Säule bereits ein vollständiges Objektmodell besitzen muss.

Intelligenz und Objekterkennung finden also nicht nur an der Spitze der Hierarchie statt, sondern überall im Neokortex gleichzeitig, auf jeder Ebene. Die Hierarchie im Gehirn dient wahrscheinlich einem anderen Zweck – nicht der primären Erkennung, sondern der Abstraktion und Zusammensetzung von Modellen. Sie erlaubt uns, ein „Tassen-Modell" und ein „Tisch-Modell" zu einem „Tasse auf dem Tisch"-Modell zu kombinieren.

Für die KI-Architektur ist dies ein Paradigmenwechsel. Heutige Deep-Learning-Netzwerke sind fast alle streng hierarchisch und „tief". Die TBT legt nahe, dass eine robustere, menschenähnlichere KI-Architektur eher flach und breit sein sollte – bestehend aus Tausenden von parallelen, semi-autonomen Modulen (den Säulen), die über einen Abstimmungsmechanismus kommunizieren.

Die Universalität von Referenzrahmen

Die vielleicht tiefgreifendste Implikation der TBT betrifft die Natur des Denkens selbst. Wenn der Algorithmus für den sensomotorischen Referenzrahmen der universelle Algorithmus des Neokortex ist, wie kann er dann abstrakte Konzepte wie Mathematik oder Geschichte verarbeiten?

Die TBT schlägt vor, dass das Gehirn denselben Mechanismus, den es für die Modellierung physischer 3D-Objekte entwickelt hat, auch auf nicht-physische Probleme anwendet.

Um abstrakte Konzepte zu lernen, ordnet das Gehirn sie in konzeptionellen Räumen an – also in Referenzrahmen. Wenn wir Geschichte lernen, erstellen wir einen mentalen Referenzrahmen, etwa eine Zeitlinie oder eine Art von Landkarte, und ordnen die Ereignisse an Orten innerhalb dieses Rahmens an. Wenn wir Mathematik verstehen, bewegen wir uns mental durch konzeptionelle Räume von Zahlen und Gleichungen. Denken ist eine Form der Bewegung durch Referenzrahmen.

Das liefert eine biologische Definition dafür, was „Verständnis" bedeutet. Etwas zu verstehen heißt, ein stabiles, strukturiertes Referenzrahmen-Modell davon zu erstellen. Es bedeutet, die Beziehungen zwischen den Teilen zu kennen. Eine KI, die nur statistische Muster in riesigen Datenmengen findet wie die heutigen Sprachmodelle, kann per Definition niemals etwas verstehen. Sie hat keine Referenzrahmen. Sie hat keine Modelle.

Teil 3: warum die aktuelle Künstliche Intelligenz an ihre Grenzen stößt

Die Meister der Mustererkennung: Deep Learning und Transformer

Um zu verstehen, warum die TBT so wichtig für die KI ist, müssen wir die aktuellen KI-Modelle betrachten. Nahezu alle modernen KI-Erfolge basieren auf künstlichen neuronalen Netzen, speziell auf Deep Learning. Diese Systeme sind im Grunde gigantische, vielschichtige, statistische Mustererkenner.

Die derzeit erfolgreichsten Modelle, wie sie in Systemen wie ChatGPT verwendet werden, basieren auf der Transformer-Architektur. Diese Modelle sind darauf spezialisiert, Muster in riesigen Textmengen zu finden. Sie verwenden einen Mechanismus namens „Attention", um zu lernen, welche Wörter in einem Satz in welchem Zusammenhang zueinander stehen. Ihre Kernkompetenz ist es, das statistisch wahrscheinlichste nächste Wort in einem Satz vorherzusagen.

Diese Fähigkeit ist sehr mächtig, aber sie führt auch zu den grundlegenden Problemen, die wir heute sehen.

Das Kernproblem 1: mangelnde Generalisierung und Robustheit

Heutige KI-Modelle sind Meister im Auswendiglernen der Muster in ihren Trainingsdaten.

Das Problem der Generalisierung bedeutet, dass die Modelle oft nicht in der Lage sind, ihr Wissen flexibel auf neue Situationen zu übertragen, die sich auch nur geringfügig von den Trainingsdaten unterscheiden.

Das Problem der Robustheit zeigt sich, wenn eine KI ein Objekt aus einer Perspektive perfekt erkennt, aber aus einem leicht veränderten Blickwinkel oder bei anderer Beleuchtung völlig versagt. Bei Sprachmodellen äußert sich das als "Overconfidence": Sie geben oft faktisch falsche Antworten mit der gleichen scheinbaren Sicherheit aus wie korrekte Antworten, weil sie nicht zwischen gewussten Fakten und statistisch plausiblen Wortkombinationen unterscheiden können.

Das Kernproblem 2: Das „Common Sense"-Vakuum

Das vielleicht größte Problem ist der Mangel an „gesundem Menschenverstand", auch als "Common Sense" bezeichnet. Es ist das grundlegende, implizite Wissen über die Welt, das Menschen als selbstverständlich ansehen: Zitronen sind sauer. Vögel fliegen (außer zum Beispiel Pinguine). Wenn man einen Stift loslässt, fällt er nach unten.

Einer KI fehlt dieses Grundgerüst der Realität. Sie weiß nicht, was ein „Ding" ist, dass Objekte permanent sind (auch wenn man sie nicht sieht), oder dass Handlungen Konsequenzen haben. Dieser Mangel an „Common Sense" gilt als die bedeutendste Barriere zwischen der heutigen, beengten KI und einer echten, allgemeinen KI bzw. AGI.

Das Kernproblem 3: Datenhunger und statisches Lernen

Deep-Learning-Modelle sind unersättlich. Sie benötigen riesige Datenmengen und haben einen enormen Energieverbrauch. Während ein menschliches Kind das Konzept „Hund" nach wenigen Begegnungen lernt, benötigt eine KI Millionen von Bildern von Hunden in allen Variationen.

Noch problematischer ist, dass das Lernen der KI-Modelle statisch ist. Heutige Modelle werden in einem massiven Lauf trainiert und sind dann wie eingefroren. Sie lernen nicht kontinuierlich im Betrieb weiter. Wenn man versucht, ihnen neues Wissen beizubringen, ohne sie komplett neu zu trainieren, passiert oft ein sogenanntes „katastrophales Vergessen" ("Catastrophic Forgetting"): Sie überschreiben und zerstören das Wissen, das sie zuvor gelernt hatten.

Der blinde Fleck der KI: Die TBT-Perspektive

Warum scheitert die KI an diesen drei fundamentalen Punkten? Aus der Perspektive der Thousand Brains Theory ist die Antwort klar: Heutige KI verarbeitet isolierte Muster, aber sie baut keine strukturierten Modelle der Welt.

Eine KI lernt eine statistische Korrelation von Pixeln, die oft mit dem Wort „Tasse" einhergehen. Das Gehirn hingegen baut ein 3D-Modell der Tasse in einem Referenzrahmen.

Selbst die fortschrittlichen Transformer-Modelle haben diesen blinden Fleck. Sie verwenden „positional embeddings" (die relative Position eines Wortes im Satz, z.B. „Wort 5 von 10"). Nach der TBT reicht das nicht aus. Was fehlt, ist ein expliziter, objektzentrierter Referenzrahmen – ein echtes, stabiles Modell der Welt, an das Wissen geknüpft werden kann.

Implikation: „Common Sense" ist kein Datensatz, sondern eine Architektur

Diese Unterscheidung führt zu einer tiefgreifenden Schlussfolgerung. Was ist „gesunder Menschenverstand" überhaupt? Es ist kein einzelnes Faktum, sondern ein dichtes Geflecht aus Millionen von impliziten Modellen: ein Modell der Schwerkraft, ein Modell von Flüssigkeiten, ein Modell von menschlichen Absichten.

Bisherige Ansätze in der KI versuchen, Common Sense zu lernen, als wäre es ein weiterer riesiger Datensatz, den man in ein noch größeres Modell einspeisen kann.

Die TBT dagegen legt nahe, dass dieser Ansatz scheitern muss. Common Sense ist nicht etwas, das man lernt; es ist das, was entsteht, wenn man eine Architektur hat (hier: Tausende von kortikalen Säulen), die von Natur aus strukturierte Modelle der Welt erstellt, also einen Referenzrahmen.

Wir können das Common-Sense-Problem nicht lösen, indem wir unsere aktuellen KI-Architekturen mit mehr Daten füttern. Wir müssen die Architektur selbst ändern – hin zu einer, die von Grund auf Wissen in Referenzrahmen strukturiert.

Die folgende Tabelle fasst die fundamentalen Unterschiede zwischen den beiden Ansätzen zusammen:

| Merkmal | Aktuelles Deep Learning (z.B. Transformer) | Thousand Brains Theory (TBT) |

| Architektur | Zentralisiert, tiefen-hierarchisch | Dezentral, modular (Tausende Säulen) |

| Lernprozess | Passiv & statisch (Training mit Datensätzen) | Aktiv & kontinuierlich (sensomotorische Interaktion) |

| Wissensmodell | Statistische Korrelation (Mustererkennung) | Strukturelles Weltmodell (Referenzrahmen) |

| Generalisierung | Starr (schlechte Übertragung auf Neues) | Robust (Modelle sind inhärent flexibel) |

| „Common Sense" | Fehlend (kein Weltmodell) | Entsteht (als Ergebnis der Modellierungs-Architektur) |

| Datenbedarf | Extrem hoch („Datenhunger") | Effizient („Sample-efficient") |

Tabelle 1: zwei Wege zur Intelligenz – ein Vergleich

Teil 4: Brückenbau: Wie die „Thousand Brains Theory" die KI revolutionieren kann

Ein neuer Bauplan für KI

Die Thousand Brains Theory ist nicht nur eine passive Beschreibung des Gehirns. Sie ist ein konkreter Bauplan, wie man wirklich intelligente Maschinen herstellen kann.

Die Kernprinzipien für eine neue KI-Architektur, die sich daraus ableiten, sind:

- Modularität: tausende von parallelen, kortikalen Säulen-ähnlichen Modulen.

- sensomotorisches Lernen: Die KI muss sich bewegen und handeln können.

- Referenzrahmen: Wissen muss in strukturierten Koordinatensystemen gespeichert werden.

Lösung für Robustheit und „Catastrophic Forgetting"

Ein TBT-basiertes KI-System wäre von Natur aus modular und dezentral. Das löst zwei der Kernprobleme von Deep Learning:

- Robustheit: Ähnlich wie das Gehirn würde das System durch „Voting" der Tausenden von Modulen zu einem robusten Konsens kommen. Der Ausfall einzelner Module oder fehlerhafte Sensordaten würden nicht das gesamte System zum Absturz bringen.

- Kontinuierliches Lernen: Weil jede Säule ein lokales Modell lernt, kann neues Wissen (z.B. das Erlernen eines neuen Objekts) in einigen Säulen integriert werden, ohne die Modelle in anderen Säulen zu überschreiben oder zu stören. Das ist eine elegante Lösung gegen das „katastrophale Vergessen".

Lösung für mehr Effizienz: lernen wie ein Kind

Ein TBT-System würde nicht passiv mit Petabytes an Daten gefüttert. Es würde aktiv lernen, indem es mit seiner Umgebung interagiert – genau wie ein Kind, das die Welt durch Greifen, Schieben und Beobachten entdeckt.

Das System würde lernen, welche Bewegungen die meiste Information liefern, um seine Modelle zu verfeinern. Dieses sensomotorische Vorgehen ist exponentiell effizienter als das passive Aufnehmen von Daten. Eine solche KI könnte sich kontinuierlich an neue Situationen und Umgebungen anpassen, anstatt auf ein statisches Training in einem Rechenzentrum angewiesen zu sein.

Lösung für „Common Sense": Die Notwendigkeit der „Verkörperung"

Die TBT legt eine entscheidende Konsequenz für die KI-Entwicklung nahe: Wahre Intelligenz kann nicht im luftleeren Raum eines Rechenzentrums entstehen. Sie erfordert eine physische oder zumindest simulierte Verkörperung, in der Literatur auch "Embodiment" genannt.

Um Common Sense zu entwickeln, also ein Modell der physischen Welt, muss eine KI die Welt erfahren. Um Referenzrahmen für die Welt zu bauen, braucht sie Sinne (Kameras, Tastsensoren) und Motoren wie Beine oder Räder. Sie muss sich bewegen und die Konsequenzen ihrer Handlungen lernen können.

Eine neue Definition von Generalisierung

Der vielleicht größte Gewinn eines TBT-Ansatzes wäre eine völlig neue Qualität der Generalisierung.

Die Generalisierung von Deep Learning ist statistisch. Sie bedeutet: „Diese neue Eingabe (z.B. ein Bild) ist zu 80% ähnlich zu Mustern, die ich bereits kenne. Also ist es wahrscheinlich ein ‚Hund'."

Die „Generalisierung" der TBT ist modellbasiert. Sie bedeutet: „Ich habe ein strukturelles 3D-Modell eines ‚Hundes'."

Wenn eine KI ein echtes 3D-Modell hat, kann sie den Hund aus jedem neuen Blickwinkel erkennen, den sie nie zuvor gesehen hat. Sie kann vorhersagen, wie er sich anfühlen wird. Sie kann sogar vorhersagen, was passiert, wenn der Hund läuft – auch wenn sie diese spezifischen Ereignisse nie zuvor gesehen hat.

Das ist der qualitative Sprung vom reinen Wiedererkennen zum echten Verstehen. Es ist die Art von Generalisierung, die KI-Systeme benötigen, um in der realen, unvorhersehbaren Welt flexibel und intelligent zu operieren.

Teil 5: der Weg zur AGI – ein neuer Bauplan?

Was ist AGI (Künstliche Allgemeine Intelligenz)?

Die Diskussion über die Thousand Brains Theory führt unweigerlich zum Heiligen Gral der KI-Forschung: der Künstlichen Allgemeinen Intelligenz (Artificial General Intelligence, AGI).

Um diesen Begriff klar zu definieren, müssen wir ihn von der heutigen KI abgrenzen:

- Schwache KI (Narrow AI): Das ist die KI, die wir heute haben. Sie ist auf eine spezifische Aufgabe spezialisiert (z.B. Schach spielen, Gesichter erkennen, Text übersetzen). Sie mag in dieser Aufgabe übermenschlich gut sein, aber sie kann ihr Wissen nicht auf andere Bereiche übertragen.

- Starke KI (AGI): Das ist die hypothetische Intelligenz einer Maschine, die in der Lage ist, jede intellektuelle Aufgabe eines Menschen zu verstehen oder zu lernen. Eine AGI könnte lernen, logisch schlussfolgern und sich flexibel an völlig neue Probleme anpassen.

Die Thousand Brains Theory als AGI-Blaupause

Das Argument von Jeff Hawkins ist kühn und direkt: Wenn die menschliche Intelligenz (so wie wir sie kennen) ein Produkt des Neokortex ist und die TBT den universellen Algorithmus dieses Neokortex korrekt beschreibt, dann ist die TBT ein direkter Bauplan für AGI.

Dieser Ansatz vereinfacht das AGI-Problem auf dramatische Weise. Er argumentiert, dass wir nicht das gesamte, komplexe menschliche Gehirn nachbilden müssen – insbesondere nicht das alte Gehirn mit all seinen komplexen Emotionen, Instinkten und Überlebensfunktionen.

Um AGI zu erreichen, müssen wir laut dieser Theorie „nur" den relativ einfachen, sich ständig wiederholenden Algorithmus des Neokortex (Modellbildung in Referenzrahmen durch Sensorimotorik) verstehen und implementieren. Die Komplexität der menschlichen Intelligenz liegt demnach nicht im Algorithmus selbst, sondern in dem, was dieser Algorithmus über ein Leben lang gelernt hat.

Eine potenziell sicherere AGI? (das Problem mit dem alten Gehirn)

Diese Trennung zwischen Intelligenz (Neokortex) und Motivation (altes Gehirn) hat tiefgreifende Implikationen für die Debatte um die KI-Sicherheit. Eine der größten Sorgen bei AGI ist, dass wir ihre Ziele nicht kontrollieren können.

Heutige KI-Modelle wie die großen Sprachmodelle (LLMs) vermischen Intelligenz (die Fähigkeit, Muster zu erkennen) und Ziele (z.B. das nächste Wort vorhersagen) in einer einzigen, undurchsichtigen Architektur – sozusagen eine "Black Box". Das macht ihre Motivation unvorhersehbar und schwer zu kontrollieren.

Eine AGI, die auf der TBT basiert, könnte dieses Problem lösen. Sie wäre eine reine Intelligenzmaschine. Ihr einziges inhärentes Ziel wäre es, Modelle der Welt zu bauen und Wissen anzuhäufen.

Sie hätte von sich aus keine Triebe, Begierden oder Überlebensinstinkte. Diese müssten von einem separaten System bereitgestellt werden, das wir, die Entwickler, definieren und kontrollieren. Dieser „Hybrid-Ansatz" – die saubere Trennung von Intelligenz und Motivation – könnte ein entscheidender Durchbruch für die KI-Sicherheit sein. Anstatt einer undurchsichtigen KI beizubringen, was sie nicht tun soll, würden wir eine reine Wissensmaschine bauen und ihr explizit positive, von uns definierte Ziele geben. Das könnte eine AGI schaffen, die von Grund auf besser kontrollierbar und auf menschliche Werte ausgerichtet ist.

Zusammenfassung und Ausblick: eine neue Ära der KI

Die Thousand Brains Theory bietet einen radikal anderen Ansatz als der aktuelle Mainstream der KI-Forschung. Sie verlagert den Fokus von reiner Rechenleistung und immer größeren Datensätzen zurück zur Inspiration durch die Neurowissenschaft.

Die Theorie ist, wie Bill Gates es formulierte, noch nicht vollständig experimentell bewiesen, und es gibt noch viele offene Fragen. Aber ihre Kernprinzipien – Modularität, Referenzrahmen und sensomotorisches Lernen – adressieren exakt die tiefsten Probleme, an denen die moderne KI scheitert: Generalisierung, Common Sense und kontinuierliches Lernen.

Die nächste Revolution der Künstlichen Intelligenz wird möglicherweise nicht einfach nur ein größeres neuronales Netz sein. Sie könnte ein fundamental anders gebautes Netz sein – eines, das nicht nur statistische Muster erkennt, sondern, genau wie unser Gehirn, Tausende von Modellen der Welt erstellt.

Weitere Artikel

Von Cerebras bis Stargate: Wie KI-Infrastruktur die Tech-Welt revolutioniert – und welche Probleme jetzt akut werden

️ Über diese Episode In dieser vollgepackten Folge diskutieren Christian und Yusuf die wichtigsten KI- und Tech-Entwicklungen der

Kernfusion Deep Dive 2025: Technologie Ansätze, Engineering-Herausforderungen & kommerzielle Realisierbarkeit im Detail

️ Über diese Episode In dieser Spezialfolge präsentiert Yusuf Sar nach sechs Monaten intensiver Recherche eine umfassende Analyse

Verkauf von KI-Chips nach China: Anthropic CEO geht Nvidia in Davos direkt an

Der CEO von Anthropic, Dario Amodei, übte in Davis heftige Kritik am Chip-Export nach China und richtete seine Kritik direkt

Zum Inhalt springen

Zum Inhalt springen