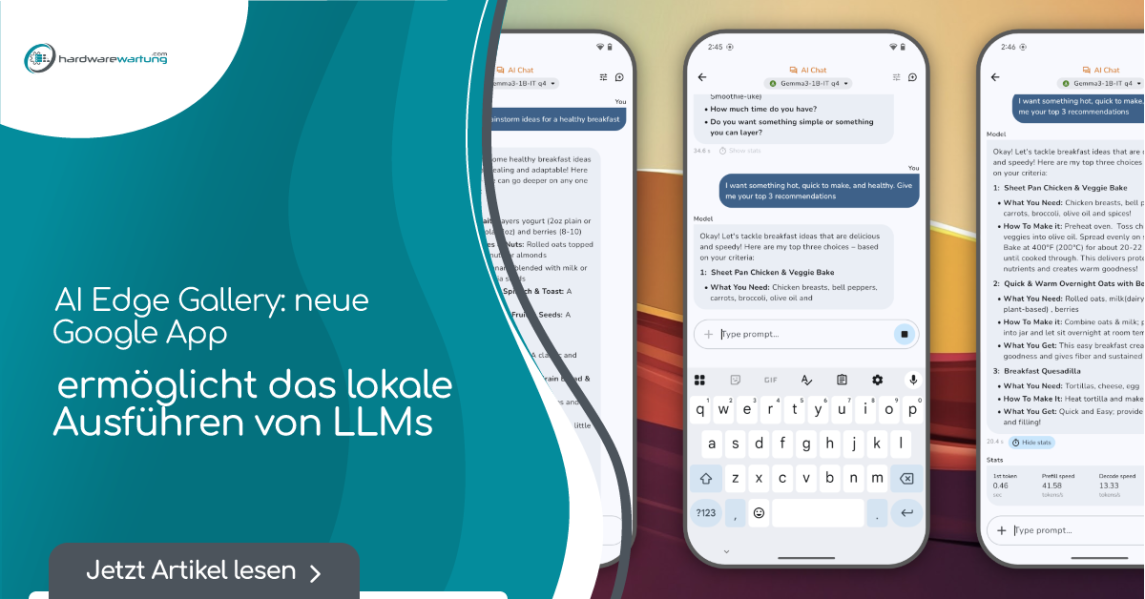

Google bietet mit der bisher kaum bekannten AI Edge Gallery App die Möglichkeit, LLMs auf einem Smartphone zu betreiben.

Die Google AI Edge Gallery ist eine neue, experimentelle App von Google, mit der man Large Language Models (LLMS) auf einem Smartphone installieren und offline verwenden kann. Das Besondere an der AI Edge Gallery ist, dass die Generative KI vollständig auf dem Gerät läuft. Das bedeutet, dass die gesamte Verarbeitung lokal stattfindet und keine Internetverbindung benötigt wird, sobald das Modell geladen ist. Das eröffnet kreative und praktische KI-Anwendungsmöglichkeiten. Benötigt wird allerdings ein modernes Smartphone wie zum Beispiel das Google Pixel 8 oder 9.

Die App ist derzeit für Android-Geräte verfügbar. Eine iOS-Version ist in Planung. Es handelt sich um eine experimentelle Alpha-Version, bei der Feedback ausdrücklich erwünscht ist.

Ihr Wartungsspezialist im DataCenter

Durch Jahrzehnte lange Erfahrung wissen wir worauf es in Ihrem Data Center ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Funktionen und Anwendungsmöglichkeiten der Google AI Edge Gallery

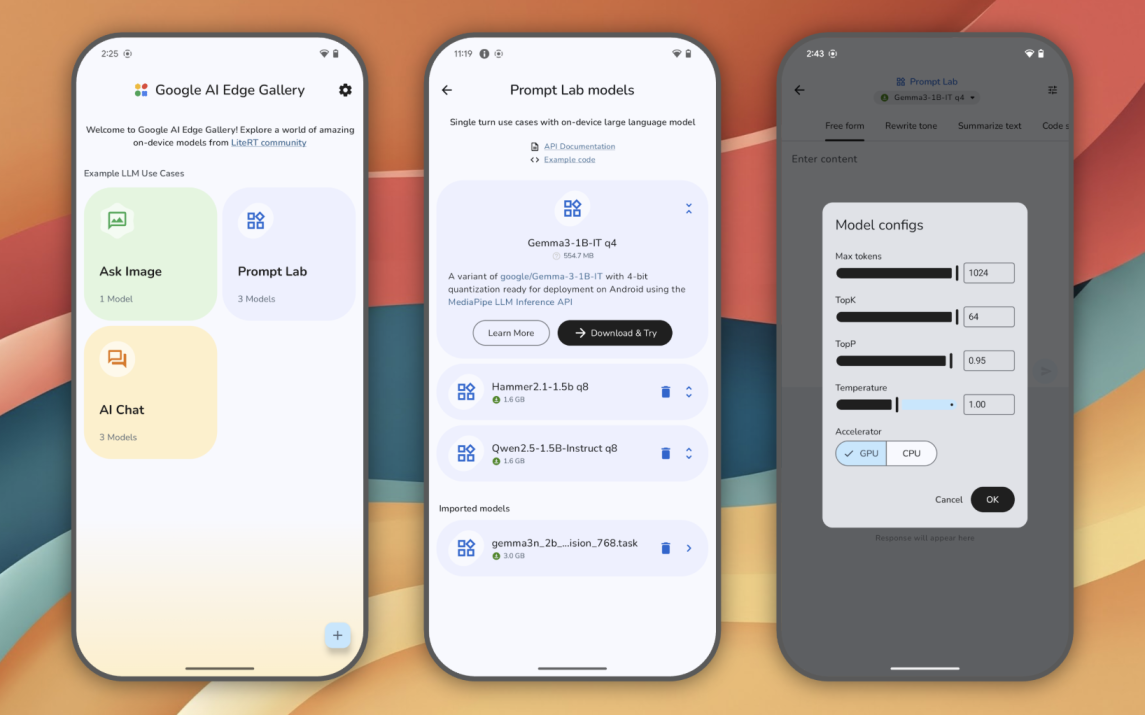

Die App bündelt verschiedene Funktionen, um die Möglichkeiten von On-Device GenAI zu demonstrieren und zu testen. Zu den Kernfunktionen gehören:

Run locally, fully offline: Alle KI-Prozesse laufen direkt auf Ihrem Gerät ohne Internetverbindung.

Choose your model: Man kann einfach zwischen verschiedenen Modellen wechseln, die man zum Beispiel von Hugging Face herunterladen kann, und deren Performance vergleichen. Die App ermöglicht es, eine Vielzahl von LiteRT-optimierten Modellen (Lite Runtime) von der Hugging Face LiteRT-Community und offiziellen Google-Releases wie Gemma 3N herunterzuladen und zu testen.

Ask Image: Über die App lassen sich Bilder hochladen und Fragen dazu stellen. Mit dieser Funktion können beispielsweise Beschreibungen abgerufen, Probleme identifiziert oder Objekte im Bild erkannt werden.

Prompt Lab: Dieser Bereich dient zur Erkundung von LLM-Anwendungsfällen mit einer einzigen Antwort. Man kann Texte zusammenfassen, umschreiben, Code generieren lassen oder freie Prompts verwenden.

AI Chat: Ermöglicht Unterhaltungen über mehrere Runden hinweg, was komplexere Interaktionen mit dem KI-Modell zulässt.

Performance Insights: Die App liefert Echtzeit-Leistungsmetriken wie die Time To First Token und die Dekodierungsgeschwindigkeit für verschiedene Modelle, die auf dem Gerät ausgeführt werden.

Bring Your Own Model: Entwickler können ihre eigenen lokalen LiteRT-Modelle in die App laden und testen.

Developer Resources: Enthalten Links zu Modellkarten und Quellcode.

Zusammenhang mit der LLM Inference API

Die Google AI Edge Gallery App dient als Beispielanwendung für die LLM Inference API. Die LLM Inference API ist eine Technologie von Google AI Edge und MediaPipe, die es ermöglicht, LLMs vollständig auf dem Gerät in Android-Anwendungen auszuführen.

Die Google AI Edge Gallery App dient als interaktiver Experimentierraum, der die LLM Inference APIs in Aktion zeigt. Sie demonstriert ein umfassendes Spektrum an On-Device-Funktionen für generative KI. Die App zeigt das Potenzial der On-Device Generative AI und zeigt, wie die LLM Inference API in realen Android-Anwendungen implementiert werden kann.

Die zugrundeliegenden Technologien umfassen Google AI Edge (Core APIs und Tools für On-Device ML), LiteRT (eine Lightweight Runtime für optimierte Modellausführung) und die LLM Inference API (die On-Device Large Language Models antreibt), sowie die Integration mit Hugging Face für den Download von Modellen.

Wie kann man die Google AI Edge Gallery App verwenden?

Um die Google AI Edge Gallery App auszuprobieren, können Sie die neueste APK-Datei herunterladen. Detaillierte Installationsanweisungen und ein vollständiges Benutzerhandbuch finden Sie im Project Wiki. Der Quellcode der Open-Source-Anwendung ist auch im Google AI Edge Gallery GitHub-Repository verfügbar.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Gute Zahlen bei ASML bestätigen anhaltenden KI-Boom

ASML, der niederländische Hersteller von Lithografiemaschinen, hat starke Zahlen vorgelegt, die zeigen, dass der Boom bei KI und dem

Von Cerebras bis Stargate: Wie KI-Infrastruktur die Tech-Welt revolutioniert – und welche Probleme jetzt akut werden

️ Über diese Episode In dieser vollgepackten Folge diskutieren Christian und Yusuf die wichtigsten KI- und Tech-Entwicklungen der

Kernfusion Deep Dive 2025: Technologie Ansätze, Engineering-Herausforderungen & kommerzielle Realisierbarkeit im Detail

️ Über diese Episode In dieser Spezialfolge präsentiert Yusuf Sar nach sechs Monaten intensiver Recherche eine umfassende Analyse

Zum Inhalt springen

Zum Inhalt springen