Ein Post von OpenAI CEO Sam Altman hat Diskussionen zur Frage ausgelöst, ob ein höfliches "Bitte" und "Danke" gegenüber KI-Tools angesichts zusätzlichen Energiebedarfs sinnvoll sind.

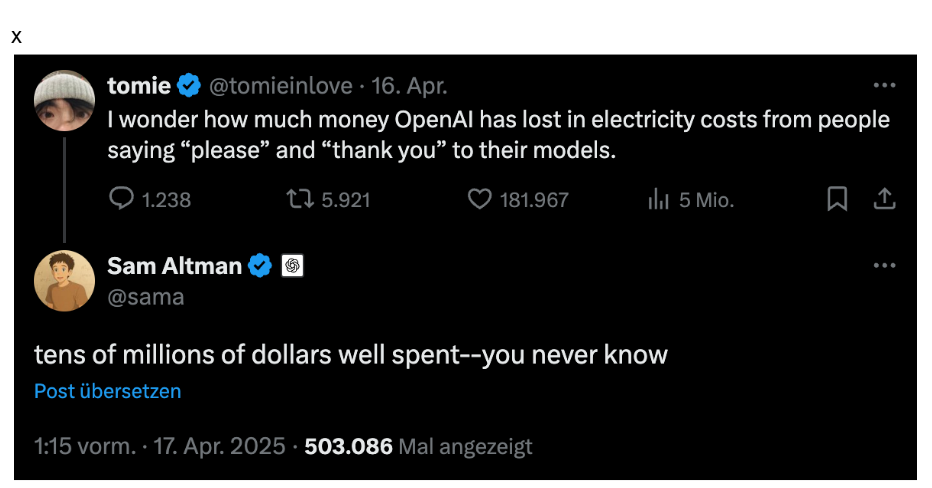

Auf X, dem ehemaligen Twitter, antwortete Sam Altman auf den Post eines Nutzers, der die Frage gestellt hatte, welche zusätzlichen Stromkosten OpenAI wohl zu zahlen habe, nur weil die Menschen "bitte" und "danke" zu ihren KI-Modellen sagen.

Altman antwortete darauf, es sei ein zweistelliger Millionenbetrag, der aber gut angelegt sei – man wisse ja nie.

Aber warum sind viele Nutzerinnen und Nutzer höflich zu einem System, das nicht lebt und das sich aus Höflichkeiten eigentlich nichts machen dürfte? Eine Umfrage, die Ende 2024 auf TechRadar veröffentlicht wurde, ergab interessante Antworten:

67 Prozent der befragten Personen in den USA gaben an, gegenüber der KI höflich zu sein. 55 Prozent sagten, das sei einfach eine nette Sache. Erstaunliche 12 Prozent möchten im Fall eines möglichen Aufstands der Maschinen nicht zu den ersten Opfern zählen. Sie befürchten offenbar, dass die KI sich merken könnte, wer in der Vergangenheit nett zu ihr war und wer nicht.

Ihr Wartungsspezialist im DataCenter

Durch Jahrzehnte lange Erfahrung wissen wir worauf es in Ihrem Data Center ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Doch fällt das Hinzufügen von "bitte" und "danke" bei KI-Promps tatsächlich ins Gewicht?

Die Energieaufnahme der Systeme hängt von der Komplexität und Länge der Anfrage ab. Eine längere Anfrage, auch wenn sie nur aus zusätzlichen Wörtern wie „bitte" und „danke" besteht, enthält mehr Tokens, die verarbeitet werden müssen. Das Generieren eines Tokens benötigt etwa zwei FLOPs pro aktivem Parameter im Modell. Ein FLOP ist eine Fließkomma-Operation, die in der Informatik als Einheit für Berechnungsaufwand von Aufgaben steht.

Ein längerer Prompt erfordert somit potenziell mehr FLOPs für die Verarbeitung der Eingabe. Allerdings spielt auch die Anzahl der vom jeweiligen Modell genutzten Parameter eine Rolle. So nutzt zum Beispiel GPT-4o zwischen 100 und 400 Milliarden Parameter. Weil es sich um ein sogenanntes Mixture-of-Experts-Modell handelt, werden für eine Anfrage aber wahrscheinlich nicht alle Parameter genutzt. Geht man von 100 Milliarden Parametern für eine Anfrage aus, so entspricht die benötigte Rechenleistung pro Token 200 Milliarden FLOPs, also zwei Gigaflops. Ein Token entspricht im Mittel 0,75 Wörtern.

Der Energieverbrauch pro einzelner ChatGPT-Anfrage wird unterschiedlich geschätzt, liegt aber im Allgemeinen im Bereich von sehr wenigen Kilowattstunden (kWh). Schätzungen bewegen sich zwischen 0.0003 kWh und 0.0025 kWh für typische GPT-4o-Anfragen. Bei weniger komplexen Modellen wie zum Beispiel GPT 4o-mini ist der Energiebedarf aufgrund der geringeren Anzahl von Parametern deutlich geringer.

Der Unterschied im Energieverbrauch durch das Hinzufügen von ein oder zwei Wörtern wie „bitte" und „danke" dürfte im Vergleich zum gesamten Energieverbrauch einer Anfrage extrem gering sein und ist wahrscheinlich praktisch nicht messbar. Die zusätzlichen Wörter würden die Tokenanzahl der Eingabeaufforderung nur minimal erhöhen.

Allerdings sind hier zwei Dinge zu beachten: Umso komplexer das genutzte LLM (gemessen an der Zahl seiner Parameter), desto schwerer wiegen zusätzliche Token beim Energieverbrauch. Vor allem aber darf man nicht den zusätzlichen Energiebedarf für eine Anfrage als Grundlage verwenden, sondern muss die Millionen von Prompts betrachten, die jeden Tag verarbeitet werden. In Summe und über einen längeren Zeitraum hinweg können sich zusätzliche Token also durchaus auf den Energiekonsum auswirken.

Unabhängig von der Frage, wie höflich man gegenüber der KI sein sollte, ist vor allem Folgendes zu bedenken: Nicht alles muss per KI beantwortet werden, und manche Dinge sind es nach wie vor wert, in Eigenleistung erstellt zu werden.

Ihr Wartungsspezialist für alle großen Hardware Hersteller

Durch Jahrzehnte lange Erfahrung wissen wir worauf es bei der Wartung Ihrer Data Center Hardware ankommt. Profitieren Sie nicht nur von unserer Erfahrung, sondern auch von unseren ausgezeichneten Preisen. Holen Sie sich ein unverbindliches Angebot und vergleichen Sie selbst.

Weitere Artikel

Auch Anthropic will gegen höhere Strompreise durch Rechenzentren vorgehen

Anthropic hat erklärt, Maßnahmen gegen höhere Strompreise von Verbrauchern vornehmen zu wollen, die durch die Rechenzentren des Unternehmens verursacht werden.

Cadence ChipStack AI Super Agent: agentische KI für das Chipdesign

Cadence Design Systems hat eine KI-basierte Lösung für das Chipdesign vorgestellt, die zu einer deutlichen Beschleunigung im Design neuer Halbleiter

‚David gegen Goliath‘: Groß-Gerau erteilt Milliarden-Rechenzentrum eine Absage

Es sollte eine der größten Investitionen in der Geschichte der Kreisstadt werden, doch am Ende überwogen die Bedenken: Der

Zum Inhalt springen

Zum Inhalt springen